EEN JURIDISCHE BLIK OP ETHISCHE

KWESTIES BIJ SOCIALE ROBOTS

Aantal woorden: 25.286

Bella Hovhannisyan

Stamnummer : 01603812

Promotor: Prof. Dr. Amy Van Looy

Masterproef voorgedragen tot het bekomen van de graad van:

Master in de Handelswetenschappen: Management en Informatica

PERMISSION

Ondergetekende verklaart dat de inhoud van deze masterproef mag geraadpleegd en/of

gereproduceerd worden, mits bronvermelding.

VOORWOORD

Met een voldaan gevoel draag ik deze masterproef voor tot het behalen van de graad van Master

in de Handelswetenschappen, afstudeerrichting management en informatica. Door de

uitzonderlijke omstandigheden waarin deze masterproef geschreven werd, dient tevens

opgemerkt te worden dat COVID-19 geen impact heeft gehad op dit onderzoek.

In de eerste plaats zou ik graag mijn promotor prof. Dr. Van Looy willen bedanken voor de

begeleiding en de vele uren die zij heeft besteed aan het lezen van dit werk. Met veel

dankbaarheid kijk ik terug op de kritische, doch rechtvaardige beoordeling van mijn promotor.

Daarnaast zou ik tevens graag alle personen willen bedanken die hebben bijgedragen aan mijn

onderzoek door deel te nemen aan een interview. Graag noem ik deze personen bij naam: Tony

Belpaeme, Tom Ederveen, Jochanan Eynikel, Brechtje Jansen, Michiel Joosse, Matthijs

Smakman, Thea Storm, Gino Vaes en Margo van Kemenade.

Een uitgebreid dankwoord gaat ook naar al mijn vrienden en collega-studenten voor de mooie

studententijd samen. Zonder hen was de weg naar dit punt een pak lastiger geweest. Naast het

doorstaan van blokperiodes waarin we elkaar steunden, wisten we ook de leukste plekken te

verkennen in Gent. Het zijn ongetwijfeld herinneringen die ik zal blijven koesteren.

Verder wil ik ook alle personen bedanken die hun kostbare tijd besteed hebben aan het nalezen

van dit werk. Hun kritische opmerkingen worden zeker geapprecieerd.

Tenslotte wil ik in het bijzonder mijn ouders graag bedanken. Zij stonden steeds aan mijn zijde,

niet enkel tijdens het schrijven van deze masterproef, maar ook gedurende de volle vier jaren

van mijn studie aan de UGent. Ik ben zeker ook een dankwoord verschuldigd aan mijn oudere

zus Laura, die altijd voor mij klaarstond en mij moed toesprak. Bedankt om een voorbeeld te

zijn naar wie ik kan opkijken en vooral bedankt om in mij te geloven, ook in tijden waar ik het

soms zelf niet meer deed.

Inhoudsopgave

Lijst van gebruikte afkortingen

... VII

Lijst van gebruikte tabellen

... VIII

Lijst van gebruikte figuren

... IX

1. Inleiding

... 1

2. Literatuurstudie

... 2

2.1 Digitalisering in de samenleving ... 3

2.2 Robots ... 4

2.2.1 Definitie ... 4

2.2.3 Verschillende typen robots en hun eigenschappen ... 5

2.2.4 Robots in de maatschappij ... 9

2.2.5 De robot en de mens ... 11

2.3 Ethiek en rechten ... 14

2.3.1 Ethiek en moraliteit ... 14

2.3.2 Rechten en rechtspersoonlijkheid ... 15

2.3.3 Aansprakelijkheid ... 16

2.3.4 Privacy ... 17

2.4 Sociale robots, ethiek en rechten ... 18

2.4.1 Morele agenten en ethiek ... 19

2.4.2 Robotethiek en wetgeving ... 21

2.4.3 Zijn sociale robots dieren? ... 24

2.4.4 Sociale robots en ouderdom ... 25

2.5 Onderzoek tot op heden ... 28

2.5.1 SLR-protocol ... 28

2.5.2 Bestaande studies over ethiek bij sociale robots in de ouderenzorg ... 35

3.3.1 Operationalisering van de vragenlijst ... 47

3.3.2 Operationalisering van de data-analyse ... 47

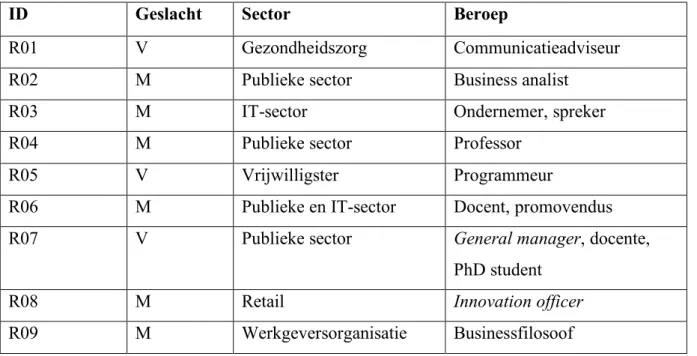

3.3.3 Voorstelling van de respondenten ... 48

3.4 Relevantie ... 52

3.4.1 Wetenschappelijke relevantie ... 52

3.4.2 Maatschappelijke relevantie ... 52

3.5 Evaluatiecriteria ... 53

3.5.1 Betrouwbaarheid... 53

3.5.2 Validiteit... 53

3.6 Informatie over het empirisch onderzoek ... 54

4. Resultaten

... 55

4.1 Impact sociale robots in de ouderenzorg op vlak van ethiek ... 55

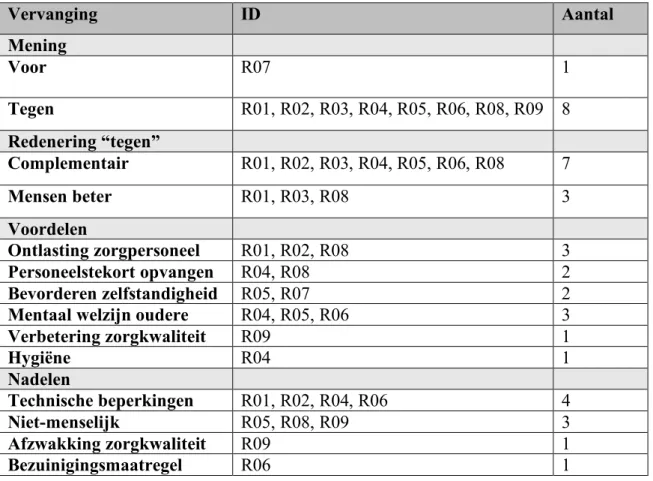

4.1.1 Vervanging zorgverleners door sociale robots ... 55

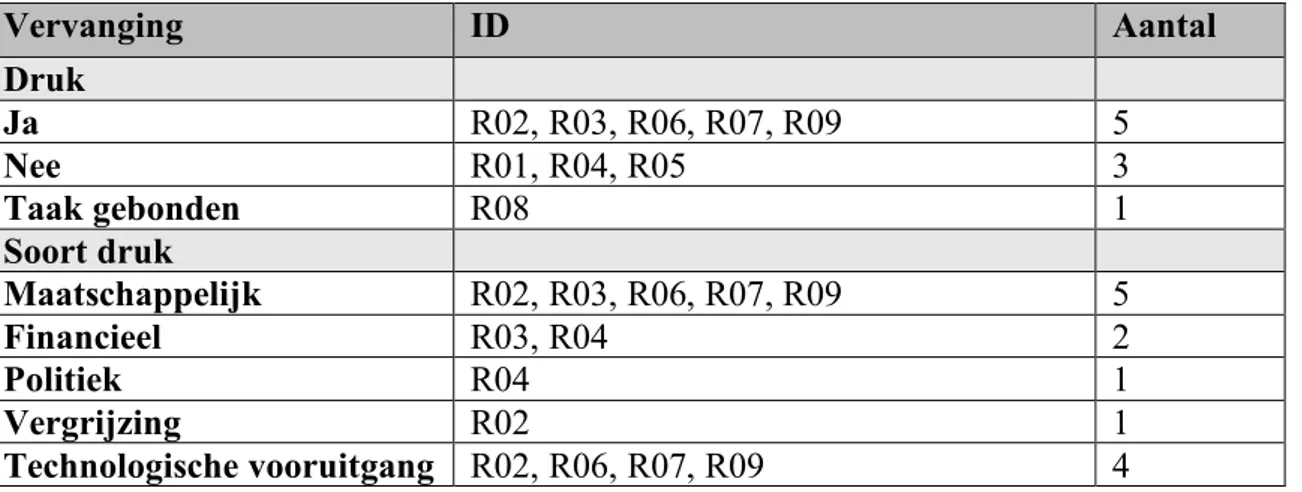

4.1.2 Waardevolle interactie en morele competenties ... 59

4.3.3 Impact op de evolutie van menselijke interactie ... 62

4.2 De rol van wetgeving bij sociale robots op ethisch vlak ... 63

4.2.1 Aansprakelijkheid van sociale robots ... 63

4.2.2 Rechtspersoonlijkheid van sociale robots ... 67

4.4.3 Verantwoordelijkheid, vertrouwen en wetgeving ... 69

4.3 De vergelijking van sociale robots met dieren op vlak van ethiek ... 74

4.3.1 Beschermen van een sociale robot... 74

4.3.2 De stelling van Kant ... 75

4.3.3 Invloed van sociale robots op kinderen ... 77

5. Discussie

... 79

5.1 Vervanging binnen de ouderenzorg ... 79

5.2 Wetgeving, aansprakelijkheid en rechtspersoonlijkheid van sociale robots ... 80

5.3 De vergelijking van sociale robots met dieren ... 82

5.4 Beperkingen van het onderzoek en toekomstig onderzoek ... 83

6. Conclusie

... 84

Bibliografie

... X

Bijlagen ... 1

Bijlage 3: Interview 1, Brechtje Jansen ... 5

Bijlage 4: Interview 2, Michiel Joosse ... 17

Bijlage 5: Interview 3, Tom Ederveen ... 24

Bijlage 6: Interview 4, Tony Belpaeme... 32

Bijlage 7: Interview 5, Thea Storm ... 45

Bijlage 8: Interview 6, Matthijs Smakman ... 53

Bijlage 9: Interview 7, Margo van Kemenade ... 61

Bijlage 10: Interview 8, Gino Vaes ... 69

Bijlage 11: Interview 9, Jochanan Eynikel ... 76

Lijst van gebruikte afkortingen

AI

Artificiële Intelligentie

AIIA

Artificiële Intelligentie Impact Assessment

BSI

British Standards Institution

GAI

Gedragscode Artificiële Intelligentie

HRI

Human Robot Interaction

IT

Information Technology

Lijst van gebruikte tabellen

Tabel 1: Typen en eigenschappen van robots ... 9

Tabel 2: SLR-protocol... 28

Tabel 3: Overzicht bestaande studies ... 30

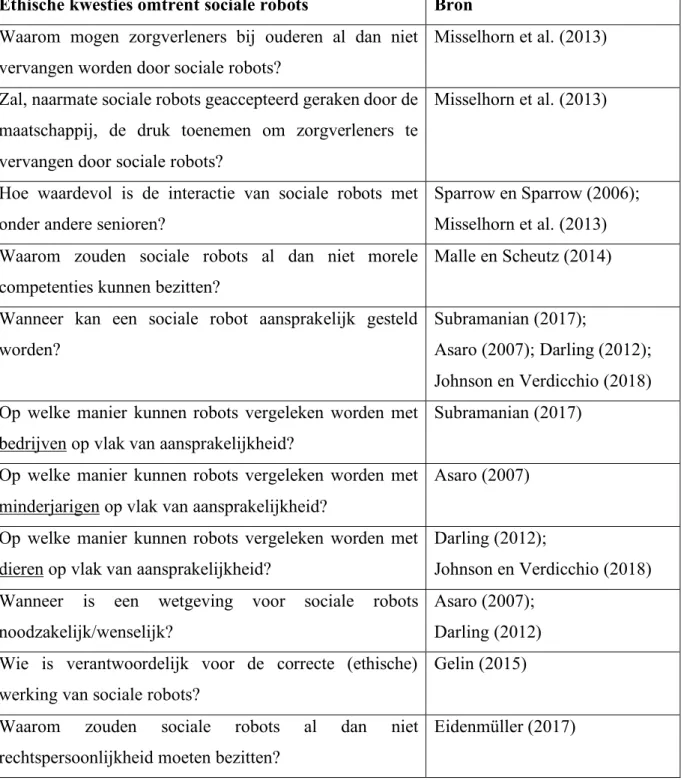

Tabel 4: Overzicht van ethische kwesties bij sociale robots ... 40

Tabel 5: Overzicht bevraagde personen ... 51

Tabel 6: Vervanging zorgverleners door sociale robots ... 56

Tabel 7: Toenemende druk voor vervanging zorgpersoneel door sociale robots ... 57

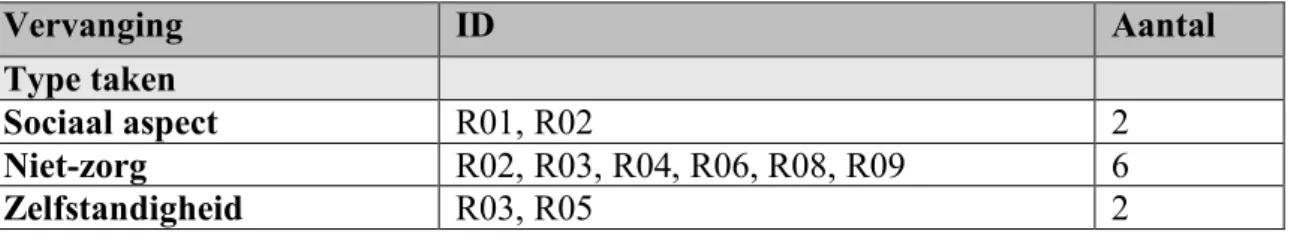

Tabel 8: Type taken bij overname door sociale robots ... 58

Tabel 9: Ethische gevolgen van vervanging door sociale robots ... 58

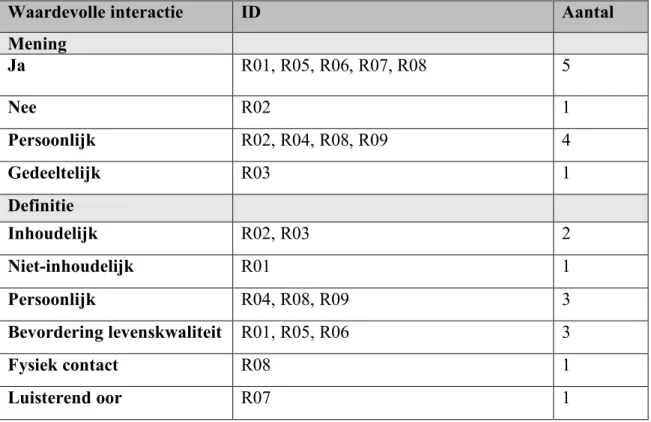

Tabel 10: Waardevolle interactie bij sociale robots ... 60

Tabel 11: Morele competenties bij sociale robots ... 61

Tabel 12: Impact sociale robots op evolutie menselijke interactie ... 62

Tabel 13: Aansprakelijkheid bij sociale robots ... 63

Tabel 14: Vergelijking sociale robots met bedrijven ... 64

Tabel 15: Vergelijking sociale robots met minderjarigen ... 65

Tabel 16: Vergelijking sociale robots met dieren ... 66

Tabel 17: Beste vergelijking sociale robot op vlak van aansprakelijkheid ... 67

Tabel 18: Rechtspersoonlijkheid toekennen aan sociale robots ... 68

Tabel 19: Toekennen rechten en plichten aan sociale robots ... 69

Tabel 20: Verantwoordelijkheid correcte ethische werking sociale robot ... 70

Tabel 21: Vertrouwen van sociale robots ... 71

Tabel 22: Licenties en opleidingen bij gebruik sociale robots ... 72

Tabel 23: Noodzakelijkheid en wenselijkheid wetgeving omtrent sociale robots ... 74

Tabel 24: Beschermen van sociale robots ... 75

Lijst van gebruikte figuren

Figuur 1: Raamwerk classificatie van sociale robots (Bartneck & Forlizzi, 2004, p. 592) ... 7

Figuur 2: Niveaus van autonomie (Crootof, 2015, p. 1864) ... 8

Figuur 3: Het griezelvallei effect (Mori, MacDorman & Kageki, 2012, p. 99) ... 13

1. Inleiding

Sociale robots komen langzaamaan steeds vaker voor in de huidige maatschappij. Het aantal

verschillende toepassingen blijft toenemen. Hierbij zijn er veel voordelen, zoals ouderen die

begeleid kunnen worden door een sociale robot (Gelin, 2015). Echter, dergelijke toepassingen

roepen al snel ethische vragen op. Dit komt mede doordat er nog geen wettelijke bepalingen

zijn omtrent sociale robots specifiek. Hoe ethisch zijn dergelijke robots bij ouderen? Waarom

zou er al dan niet een wetgeving moeten komen? Kunnen ze vergeleken worden met dieren?

Deze masterproef tracht een antwoord te geven op dergelijke vragen. Er wordt namelijk

onderzocht wat de visie is van experten op bepaalde ethische kwesties omtrent sociale robots.

Op deze manier kan een beeld gevormd worden van de ethiek bij sociale robots en de

wenselijkheid van een wetgeving. Ter afsluiting worden er uiteindelijk beleidsadviezen

geformuleerd.

2. Literatuurstudie

In deze literatuurstudie zal eerst kort de digitaliserende samenleving besproken worden. Daarna

zullen robots in het algemeen bekeken worden en in de loop van dit werk wordt er specifieker

ingegaan op sociale robots.

Vermits ethiek en rechten zeer breed opgevat kunnen worden, zullen deze concepten

ook nader toegelicht worden in het derde deel van de literatuurstudie. Dit zal zorgen voor een

afbakening van deze begrippen.

Verder zal het vierde deel een combinatie bevatten van beide hoofdconcepten, met name

sociale robots en de ethische/juridische kwesties met betrekking tot dit soort robots.

Uiteindelijk wordt de literatuurstudie afgesloten met een vergelijking van bestaande

onderzoeken. Dit zal resulteren in een overzichtelijke weergave van nieuwe

onderzoeksmogelijkheden voor in de toekomst.

2.1 Digitalisering in de samenleving

De huidige maatschappij krijgt te maken met digitalisering en robotisering (Van Humbeeck,

Buyse, Knaepen, & Morsink, 2017). Alhoewel er volgens Van Humbeeck et al. (2017) nog

geen sprake is van een digitale samenleving, zijn er toch reeds bepaalde invloeden die

ondervonden kunnen worden, schrijven de auteurs. Er is ook een toenemende angst voor

robotisering en automatisering (Van Lancker, 2018). Vooral de bouw, transport, landbouw,

industrie en dienstverlening zijn sectoren die kwetsbaar zijn voor deze twee fenomenen (Van

Lancker, 2018).

De grootste groei van robots vindt plaats in de industrie, waarbij er sprake is van industriële

robots (Hindriks, 2017). De ontwikkeling, waarbij menselijke arbeid op grote schaal vervangen

wordt door machines, wordt de robothypothese genoemd (Thomas, 2015). Zo zullen onder

andere bepaalde jobs verdwijnen en andere ontstaan (Van Lancker, 2018). Echter, ook in het

dagelijks leven zullen steeds meer robots aanwezig zijn (Hindriks, 2017).

Verder heeft de robothypothese niet enkel een invloed op de arbeidsmarkt, maar ook op het

onderwijs (Thomas, 2015). Zo zullen er als gevolg van technische veranderingen bepaalde

vaardigheden bevoordeeld worden (Card & DiNardo, 2002). Dit zijn vaardigheden, zoals

bijvoorbeeld creativiteit en veerkracht, waarmee men zich kan gaan onderscheiden van

machines (Thomas, 2015). Het hoger onderwijs wordt ook steeds belangrijker, stelt Thomas

(2015). Echter, volgens Goldin en Katz (2009) maakt een diploma iemand niet langer

onmisbaar.

Ten slotte heeft technologische vooruitgang reeds in het verleden gezorgd voor grote

veranderingen in de samenleving (Van Lancker, 2018). Na de industriële revoluties van

vroeger, komt er ook nu een nieuw technologisch tijdperk dichterbij met disruptieve

2.2 Robots

2.2.1 Definitie

Alle robots zijn machines, maar niet alle machines zijn robots (Loh, 2019). De definitie van een

machine is volgens Loh (2019): “an artificial structure that consists of individual parts moved

by a drive system (motor, wind, water, etc.) and converts energy.” (p. 6).

Daarnaast definieert Turney (2015) een robot als: “oorspronkelijk een mensachtige machine die

menselijke arbeid overnam, . . . . Robots worden nog altijd vaak als mensachtig voorgesteld,

maar de term wordt ook gebruikt voor alle toestellen of computerprogramma’s die enige vorm

van ‘agency’ (gericht handelen) vertonen of nabootsen.” (p. 13). Hierbij ligt de nadruk op de

taak en het uiterlijk van robots. Fong, Thorpe en Baur (2003) definiëren robots als machines of

toestellen die taken kunnen uitvoeren op vraag van mensen.

Het voorgaande begrip mag echter niet verward worden met robotica die gedefinieerd

wordt als “. . . een bredere term dan robot en heeft betrekking op computertoepassingen die in

het dagelijks leven zijn geïntegreerd, zoals de personal assistant in je smartphone, het

navigatiesysteem in je auto en de intelligente thermostaat in je huis.” (Turney, 2015, p.13).

Hieruit kan afgeleid worden dat robots wel robotica zijn, maar niet alle robotica zijn robots.

Verder kan ook specifiek een sociale robot gedefinieerd worden. Darling (2012) beschrijft een

sociale robot als: “a physically embodied, autonomous agent that communicates and interacts

with humans on a social level.” (p. 2). In deze definitie wordt er benadrukt dat de focus op

interactie met mensen ligt. Daarnaast is er ook nog een algemene, maar gelijkaardige definitie,

namelijk: “. . . machines that are able to interact with one another and/or with humans in social

ways.” (Sandry, 2015, p.335). Ook de volgende definitie benadrukt de sociale interactie met de

mens: “Een sociale robot is een robot die met mensen kan communiceren.” (Hindriks, 2017,

p13). Sheridan (2020) legt ook de nadruk op interactie, maar linkt dit aan het verschil met

industriële robots. De onderzoeker definieert sociale robots namelijk als “one whose purpose

is to serve a person in a caring interaction rather than to perform a mechanical task.” (p. 7).

Bovendien definieert Breazeal (2003) sociale robots als: “. . . the class of robots that

Nourbakhsha en Dautenhahn (2003) meer op de karakteristieken van de robot zelf. Hun

definitie luidt als volgt: “Social robots are embodied agents that are part of a heterogeneous

group. . . . They are able to recognize each other and engage in social interactions, they possess

histories (perceive and interpret the world in terms of their own experience), and they explicitly

communicate with and leam from each other.” (p. 144). Daarnaast definiëren Bartneck en

Forlizzi (2004) sociale robots als “. . . products that facilitate co-experience and social

interaction.” (p. 592).

Ten slotte bestaan binnen de groep van sociale robots ook specifiekere soorten, zoals de sociale

assistentie robots (SAR) en de humanoïde robots. SAR zijn robots die sociale interactie en

assistentie verlenen aan de gebruiker, zonder dat fysiek contact hierbij noodzakelijk is (Di

Nuovo et al., 2017). Humanoïde robots zijn ook sociale robots, maar vertonen gelijkenissen

met mensen op vlak van gedrag en uiterlijk (Johnson & Verdicchio, 2018). Deze gelijkenissen

worden steeds sterker, waardoor er speculaties zijn dat mensen in de toekomst een humanoïde

robot boven een echt mens zouden verkiezen als levenspartner (Johnson & Verdicchio, 2018).

2.2.3 Verschillende typen robots en hun eigenschappen

Bovendien zijn er binnen de groep van robots ook verschillende soorten robots. Ut infra zullen

enkele van de typen robots besproken worden samen met hun eigenschappen die ervoor zorgen

dat ze onderscheiden worden van de andere robots. Deze lijst is echter niet bedoeld om

allesomvattend te zijn, maar om een beeld te schetsen van robots die relevant zijn binnen deze

literatuurstudie.

Ten eerste schreven Royakkers, Daemen en van Est in 2012 dat er twee groepen van robots

kunnen onderscheiden worden, namelijk service robots en industriële robots. Service robots

zijn alle robots die, al dan niet autonoom, een bepaald nut bijbrengen aan mensen en instanties,

maar niet ingezet worden in fabrieken (Royakkers et al., 2012). Ze verlenen diensten, zorg en

In tegenstelling tot de service robots, worden industriële robots voornamelijk ingezet bij

massaproductie in fabrieken doordat ze beperkt zijn tot een specifiek aantal taken (Ebel, 1986).

Ze worden dan ook door de Internationale Organisatie voor Standaardisering (ISO)

gedefinieerd als een “automatically controlled, reprogrammable, multipurpose, manipulator

programmable in three or more axes, which may be either fixed in place or mobile for use in

industrial automation applications.” (ISO 8373). Zoals reeds besproken in sectie 1 van deze

literatuurstudie, hebben deze robots een grote impact op de arbeidsmarkt en dus op de

samenleving.

Daarnaast kan men ook een andere groep van robots onderscheiden, namelijk de sociale robots.

Deze werden reeds gedefinieerd in sectie 2.1. Breazeal schreef in 2003 dat er binnen deze groep

vier verschillende soorten sociale robots bestaan, namelijk: sociaal suggestieve, sociale

interface, sociaal ontvankelijke en sociaalvriendschappelijke robots. Daarenboven is de

humanoïde robot een specifieke sociale robot met menselijke kenmerken die flexibel kan

werken en kan ingezet worden voor een wijde selectie aan taken (Adams, Breazeal, Brooks, &

Scassellati, 2000). Dit is dan ook het grootste verschil met industriële robots, die worden

namelijk in een vaste omgeving ingezet voor een klein bereik aan taken (Adams et al., 2000).

Ook nemen sociale robots beslissingen op basis van hun interne staat en percepties, terwijl

industriële robots zich baseren op zeer specifiek geprogrammeerde commando’s (Scheutz,

2012). Het feit dat sociale robots in staat zijn om gedeeltelijk zelf te beslissen over het gedrag

en de acties die ze vertonen, is dan ook een verschilpunt met niet-sociale robots (Lutz & Tamò,

2015).

Bartneck en Forlizzi (2004) beschrijven in hun onderzoek een raamwerk waarmee

sociale robots geclassificeerd kunnen worden op basis van hun vorm, modaliteit, sociale

normen, mate van autonomie en interactiviteit. In dat raamwerk staat het ontwerp van de robot

centraal. Onder ‘vorm’ verstaat men niet enkel de vorm, maar ook de materialen en

gedragseigenschappen van de robot. Deze vorm kan volgens de auteurs abstract, biomorf of

antropomorf zijn. Biomorf betekent dat de robot een levensecht object nabootst, terwijl

antropomorf verwijst naar het nabootsen van een mens (Bartneck & Forlizzi, 2004). Modaliteit

beschrijven Bartneck en Forlizzi (2004) als het aantal betrokken communicatiekanalen. Hierbij

kan het volgens deze onderzoekers om een of meerdere communicatiekanalen gaan,

beïnvloed door het gedrag van andere leden binnen een sociale groep, hierbij spreekt men van

sociale normen (Bartneck & Forlizzi, 2004). Deze sociale normen worden verkregen door

middel van interactie tussen mensen (Bartneck & Forlizzi, 2004). Hierdoor stellen Bartneck en

Forlizzi (2004) dat ze ook gedefinieerd kunnen worden door interacties tussen mensen en

robots. Daarnaast is ook autonomie opgenomen in het raamwerk. Dit wordt gedefinieerd als “.

. . having the technological capabilities to act on behalf of humans without direct input from

humans.” (Bartneck & Forlizzi, 2004, p. 593). Een robot kan geen, enige of volledige

autonomie bezitten, stellen Bartneck en Forlizzi (2004). Tenslotte kan een sociale robot volgens

de onderzoekers ook geclassifieerd worden op basis van de mate van interactiviteit. De

onderzoekers definiëren dit als volgt: “. . . having the potential to exhibit causal behavior - that

is, to respond in reaction to interaction with a human.” (p. 593).

Onderstaande figuur geeft het raamwerk weer voor de classificatie van sociale robots dat ut

supra besproken werd.

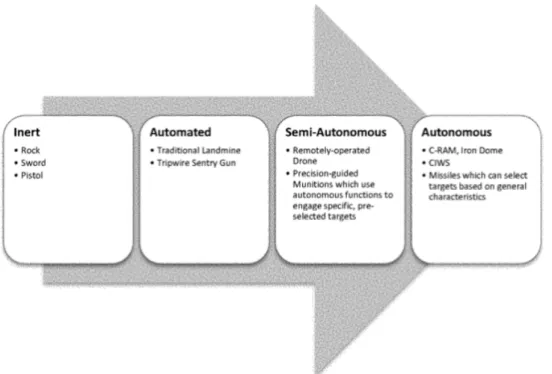

zijn autonome wapensystemen die Crootof (2015) definieert als “a weapon system that, based

on conclusions derived from gathered information and preprogrammed constraints, is capable

of independently selecting and engaging targets.” (p. 1837). Zoals figuur 2 ut infra aantoont,

zijn er hierbij verschillende niveaus van autonomie.

Figuur 2: Niveaus van autonomie (Crootof, 2015, p. 1864)

Verscheidene auteurs zijn kritisch over hoe ethisch dergelijke militaire robots zijn, aangezien

ze ook wel moordende robots worden genoemd (Lokhorst & van den Hoven, 2012). Echter,

Lokhorst en van den Hoven (2012) wijzen erop dat niet elke militaire robot een moordende

robot is, en indien dit toch het geval is, het ook op ethisch correcte wijze kan gebeuren.

Tenslotte is er ook een vijfde soort robots, namelijk de autonoom mobiele robots. Deze robots

kunnen bewegingen uitvoeren en/of zich verplaatsen op zelfstandige basis (Siegwart,

Nourbakhsh, & Scaramuzza, 2011). De robots worden in verschillende sectoren ingezet,

bijvoorbeeld de farmaceutische sector en de auto-industrie (Fahimi, 2009). Een voorbeeld van

een autonoom mobiele robot die Fahimi (2009) in zijn werk beschrijft is de autoachtige robot.

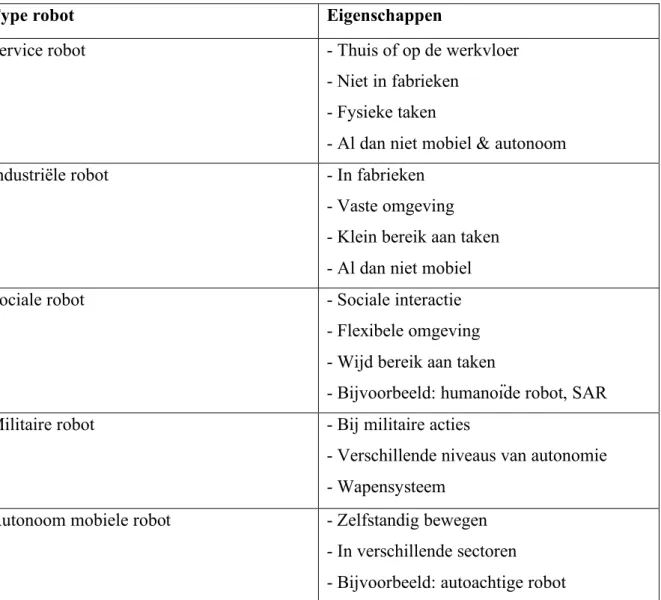

Tabel 1 vat de verschillende eigenschappen per besproken type robot samen.

Tabel 1: Typen en eigenschappen van robots

Type robot

Eigenschappen

Service robot

- Thuis of op de werkvloer

- Niet in fabrieken

- Fysieke taken

- Al dan niet mobiel & autonoom

Industriële robot

- In fabrieken

- Vaste omgeving

- Klein bereik aan taken

- Al dan niet mobiel

Sociale robot

- Sociale interactie

- Flexibele omgeving

- Wijd bereik aan taken

- Bijvoorbeeld: humanoïde robot, SAR

Militaire robot

- Bij militaire acties

- Verschillende niveaus van autonomie

- Wapensysteem

Autonoom mobiele robot

- Zelfstandig bewegen

- In verschillende sectoren

- Bijvoorbeeld: autoachtige robot

2.2.4 Robots in de maatschappij

De hierboven besproken typen robots bevinden zich reeds in de huidige maatschappij en kennen

ook tal van toepassingen (Lin, 2012). Enkele toepassingen bij kinderen met autisme, in de

ouderenzorg, binnen het onderwijs en bij mensen thuis zullen hierna besproken worden ter

‘sociale verhalen’ aan autistische kinderen. De auteurs Vanderborght, et al. (2012) omschrijven

deze “sociale verhalen” als korte scenario’s om autistische personen correct te leren handelen

in sociale situaties door deze beter te doen begrijpen. Kinderen met autisme ondervinden

namelijk moeilijkheden bij sociale interactie (Vanderborght et al., 2012), alsook bij het

identificeren van emoties in specifieke situaties (Pop et al., 2013). Kinderen die moeilijkheden

ondervinden bij sociale communicatie, hebben potentieel baat bij deze sociale robots (Ismail,

Hanapiah, Belpaeme, Dambre, & Wyffels, 2020). Bovendien interageren ze liever met

objecten, zoals robots, dan met mensen, waardoor deze kinderen er op sociaal vlak beter op

vooruitgaan indien een robot de ‘sociale verhalen’ voorleest (Vanderborght et al., 2012).

Een tweede toepassing is de sociale assistentie robot bij ouderen. Deze werd reeds gedefinieerd

in sectie 1.1. Robots die sociale interactie hebben met mensen zorgen bij hun voor een stijging

van positieve gevoelens en een stijgende wil tot interactie (Fraune et al., 2020). Uit het

onderzoek van Di Nuovo et al. (2018) bleek dit ook het geval te zijn bij ouderen. In hun

onderzoek hadden ouderen die minder ervaren waren met technologische toestellen, het meeste

baat bij dergelijke sociale assistentie robots.

Een concreet voorbeeld van het voorgaande is de zeehond Paro. Deze robot wordt ingezet in

residenties waar ouderen verblijven (Leite, Martinho, & Paiva, 2013). Dit gebeurt bijvoorbeeld

bij de behandeling van patiënten met dementie (Darling, 2012). Uit het onderzoek van Di

Nuovo et al. (2018), waarbij twee Paro robots werden ingezet in de residentie, bleek dat deze

voor een sterkere sociale band zorgden tussen de ouderen van de residentie. Bovendien

ontwikkelden deze ouderen een matige tot sterke band met de robot, waardoor het gevoel van

eenzaamheid verminderde (Robinson, MacDonald, Kerse, & Broadbent, 2013).

Di Nuovo et al. (2018) stelden tevens vast dat het stressgehalte van de ouderen verlaagd

was nadat Paro in de residentie werd gebruikt. Naast deze voordelen, dient ook opgemerkt te

worden dat sociale robots door het publiek gezien worden als duur (Di Nuovo et al., 2017).

Ondanks het feit dat sociale robots in bepaalde situaties reeds fungeren als surrogaat voor een

mens (Subramanian, 2017), mogen ze in dit geval enkel ter assistentie van het zorgpersoneel

dienen en hen dus niet vervangen (Runhaar, 2014). Ook Barata (2019) deelt deze mening in

haar onderzoek.

Bovendien zijn er ook nog toepassingen binnen het onderwijs. Sociale robots zouden dezelfde

voordelen hebben voor studenten zoals virtuele pedagogische agenten die reeds gebruikt

worden in het onderwijs (Di Nuovo et al., 2017). Uit het onderzoek van Di Nuovo et al. (2017)

blijken jongere kinderen meer betrokken te zijn met robots. Een mogelijke oorzaak is dat

jongere kinderen minder verwachtingen hebben over het gedrag van de robot en het meer zien

als speciaal of nieuw speelgoed (Di Nuovo et al., 2017). Eén van de robots in het onderzoek

van Di Nuovo et al. (2017) is Robovie, een robot die gebruikers kan herkennen en Engels kan

spreken. Hierbij bleek de implementatie van nieuw gedrag belangrijk te zijn om de jonge

gebruikers betrokken te houden bij dergelijke robots (Di Nuovo et al., 2017).

Verder kennen robots ook toepassingen bij mensen thuis. Een voorbeeld hiervan is de

robotdinosaurus Pleo, een interactief speeltje voor kinderen thuis (Fernaeus, Håkansson,

Jacobsson, & Ljungblad, 2010). In het onderzoek van Fernaeus et al. (2010) bleek dat de

kinderen Pleo als een echt dier behandelden door bijvoorbeeld het te aaien of het een naam te

geven. Het onderzoek toonde echter ook aan dat dit niet voldoende was om op lange termijn de

kinderen geïnteresseerd te houden in Pleo.

Ten slotte blijken ouderen en kinderen gelijkenissen te vertonen bij de acceptatie van deze

robots (Frennert & Östlund, 2014). Ze hebben beiden weinig kennis van de achterliggende

technologie, een groot verlangen naar sociaal contact en bovendien vertonen beide groepen een

positief gedrag tegenover robots (Frennert & Östlund, 2014). Acceptatie van dergelijke robots

is dan ook cruciaal bij de relatie tussen robots en ouderen (Frennert & Östlund, 2014).

2.2.5 De robot en de mens

Bij de hierboven besproken toepassingen blijkt interactie tussen robots en mensen een

aanzienlijke rol te spelen. Toepassingen van robots in ziekenhuizen, scholen, residenties, etc.

leiden dan ook tot human-robot interaction (HRI) (Azmin, Shamsuddin, & Yussof, 2016). Er

informatieverwerving en -analyse uit de omgeving. Ze omschrijven actie als de reactie van de

robot nadat het signalen heeft ontvangen. Daarnaast stellen deze onderzoekers dat het

intermediair mechanisme slaat op het “geheugen” van de robot die de perceptie en actie met

elkaar verbindt. HRI fungeert dan ook als brug tussen een sociale robot en de omgeving waarin

het zich bevindt (Yan et al., 2014).

Bovendien bepaalt, bij de relatie tussen een robot en een mens, het uiterlijk hoe de interactie

wordt opgebouwd en ervaren (Coeckelbergh, 2010). Natuurlijke HRI is dan ook een vorm van

HRI waarbij mensachtige robots op dezelfde manier interactie voeren met mensen zoals mensen

onderling (Kanda, 2010). Echter, opdat mensen interactie zouden voeren met sociale robots,

zijn menselijke uiterlijke kenmerken bij de robot geen vereiste (Onyeulo & Gandhi, 2020).

Dergelijke kenmerken kunnen wel ten goede komen van de interactie tussen een mens en een

robot (Onyeulo & Gandhi, 2020). Deze kenmerken zorgen namelijk voor meer affiniteit (Mori,

MacDorman, & Kageki, 2012). Sociale robots zijn dan ook de robots die het vaakst ontworpen

worden met menselijke kenmerken (Sandry, 2015). Deze kenmerken zorgen ervoor dat

interactie met de robot toegankelijker wordt voor de mens (Sandry, 2015). Bij dergelijke robots

is het gezicht belangrijk, aangezien deze een invloed heeft op de eerste indruk die mensen

vormen (Broadbent et al., 2013). Daarbij zijn de ogen het belangrijkste, want daaruit kan de

levendigheid van degene waarmee men interactie heeft, afgeleid worden (Looser & Wheatley,

2010). Tevens Stroessner en Benitez (2019) ondervonden in hun onderzoek dat mensen een

voorkeur hebben voor robots met meer menselijke gezichtskenmerken, maar ook vooral

vrouwelijke robots. Daarnaast schreven Onyeulo en Gandhi (2020) dat het niet vereist is dat

een robot op dezelfde manier reageert als een mens. Het gedrag van de robot dient voorspelbaar

te zijn en de robot moet op een logische manier reageren tijdens de interactie met de mens,

stellen de onderzoekers. Indien een robot foutief gedrag vertoont, dan daalt de betrouwbaarheid

en voorspelbaarheid van de robot bij mensen (Salem, Lakatos, Amirabdollahian, &

Dautenhahn, 2015). Echter, merken Salem et al. (2015) hierbij op dat ondanks deze daling, de

robot door de gemaakte fouten wel als menselijker wordt waargenomen.

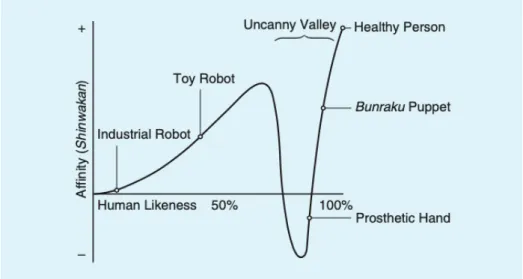

Daarnaast zorgt een robot die te veel op een mens lijkt, zeer humanoïde robots, voor een

averechts effect dat de griezelvallei wordt genoemd (Mori et al., 2012). Turney (2015) beschrijft

dit effect als volgt: “. . . mensen lijken zich ongemakkelijk te voelen tegenover robots die er min

betekent dat hoe menselijker de robot eruitziet, hoe meer affiniteit, tot een bepaald punt bereikt

wordt (Mori et al., 2012). Als dit punt bereikt is, waarbij de robot ongeveer 80 tot 85 procent

gelijkenissen vertoont met de mens, neemt de affiniteit sterk af (Mori et al., 2012). Dit komt

doordat de mens zowel een robot als een mens herkent in de humanoïde robot, waardoor er een

intern conflict ontstaat (Mori et al., 2012). Dit effect wordt weergegeven in figuur 3.

Figuur 3: Het griezelvallei effect (Mori, MacDorman & Kageki, 2012, p. 99)

Verder bestaat er ook een ander effect bij de relatie tussen een mens en een robot. Darling

schreef in 2012 dat uit psychologisch onderzoek blijkt dat mensen zich emotioneel gaan hechten

aan objecten, dit wordt het verzorgereffect genoemd. Dit effect blijkt nog sterker te zijn ten

aanzien van sociale robots, omwille van 3 factoren: lichamelijkheid, waarneembare autonome

beweging en sociaal gedrag (Darling, 2012). Door deze factoren vertonen mensen ander gedrag

tegenover sociale robots in vergelijking met andere objecten waarbij het verzorger effect minder

sterk aanwezig is (Darling, 2012). Robots delen onze fysieke ruimte, daarom is deze hechting

dan ook te verwachten, zeker als ze menselijke capaciteiten bezitten (Leite et al., 2013).

Dergelijk verzorger effect kan ook negatief zijn als hierdoor bijvoorbeeld menselijke interactie

2.3 Ethiek en rechten

2.3.1 Ethiek en moraliteit

Zoals het voorgaande reeds aantoonde, blijkt ethiek al snel een belangrijk rol te spelen. Gabriels

(2019) definieert ethiek dan ook als volgt: “Ethiek verwijst naar een specifieke filosofische

discipline die een systematische en kritische reflectie op moraliteit beoogt” (p. 25). Ethiek is

van belang op niveau van de maatschappij, de technologie, de maker en de gebruiker (Gabriels,

2019). Ethiek kan dan ook zowel als moeilijk, en als gemakkelijk gezien worden (Nath & Sahu,

2017). Enerzijds is het gemakkelijk omdat men dagelijks ethisch handelt, anderzijds is het

moeilijk omdat de achterliggende criteria bij dergelijke ethische handelingen niet simpel

achterhaald en gecodeerd kunnen worden (Nath & Sahu, 2017). Bovendien is ethiek niet enkel

achteraf van belang, maar ook voor en tijdens het ontwikkelingsproces van de technologie

(Gabriels, 2019). De technologie is dan het resultaat van al dan niet morele keuzes (Gabriels,

2019).

Daarnaast dient er een onderscheid gemaakt te worden tussen ethiek en moraliteit, deze zijn

immers geen synoniemen, stelt Gabriels (2019). In haar werk beschrijft de auteur moraliteit als

een individuele blik op normen en gewoontes, die varieert per specifieke culturele context.

Bovendien kunnen mensen reflecteren over hun eigen gedrag, normen, waarden, etc. omdat ze

morele wezens zijn (Gabriels, 2019). Een morele daad is dan ook een daad die tegenstrijdig is

met hetgeen waarnaar men verlangt en de wet niet overtreedt (Beavers, 2009). Indien iemand

een handeling uitvoert die niet in strijd is met de wet en dit gebeurde uit eigen wil, dan is die

persoon minder moreel in vergelijking met iemand die dezelfde handeling doet maar dit

eigenlijk niet wou doen (Beavers, 2009).

Tenslotte zijn er volgens Gabriels (2019) binnen de moraliteit enkele belangrijke aspecten.

Twee daarvan zijn morele chaos en morele ontkoppeling. Het eerste houdt in dat mensen niet

altijd handelen naar hun woorden (Gabriels, 2019). Het tweede is een mechanisme waarbij

gedrag dat niet aansluit bij de morele waarden en normen, gerechtvaardigd wordt (Gabriels,

2019).

2.3.2 Rechten en rechtspersoonlijkheid

Verder vormen naast ethiek ook rechten en rechtspersoonlijkheid een belangrijk onderdeel

binnen deze literatuurstudie. Een duidelijke afbakening van het begrip ‘recht’ zou mede helpen

om criteria te vormen om af te toetsen wat er nu precies onder het begrip rechtspersoon valt

(Calverley, 2011). Een belangrijke illustratie hiervan is de discussie of machines al dan niet als

rechtspersoon kunnen worden gezien (Calverley, 2011). Moore (2014) definieerde het recht als

een sociale constructie die ervoor zorgt dat burgers weten wat ze kunnen, wel mogen en niet

mogen doen, maar ook tot wat ze gerechtigd zijn. Daarnaast omvat het ook alle instituties die

zowel deze wetten maken als afdwingen (Morse, 2004). Echter, Calverley schreef in 2011 dat

bovenstaande definitie bedrieglijk is. Hij stelde dat het rechtssysteem kan gezien worden als

een formele opeenstapeling van praktische oordelen, een opslagplaats van kennis. Daarnaast

kan volgens Marx en Tiefensee (2015) ‘recht’ niet losgekoppeld worden van ‘plicht’. Ze

beschrijven dit verband als volgt: “A has a right to X if and only if B has a duty towards A to

act in a way that does not hinder A from attaining X or that promotes A ' s attaining X.” (p.

71). De auteurs merken wel op dat het omgekeerde niet geldt.

Bovendien dient men om van rechten te kunnen genieten, rechtspersoonlijkheid te bezitten

(Smith, 1928). Rechtspersoonlijkheid impliceert echter ook dat men plichten heeft (Solaiman,

2017). Elke entiteit, ongeacht of men een mens is of niet, die de capaciteiten heeft om rechten

en plichten te bezitten, is dan ook een rechtspersoon, stelt Solaiman (2017). Zowel natuurlijke

personen, als rechtspersonen bezitten rechtspersoonlijkheid (Westenbroek, 2016). Een

rechtspersoon is een entiteit gecreëerd door de wetgever en is tevens een erkende rechtsvorm

(Westenbroek, 2016). Op die manier kan men zelfstandig in het maatschappelijk verkeer

optreden, eigen bezittingen hebben, in rechte optreden, verplichtingen aangaan en rechten

hebben (Westenbroek, 2016).

2.3.3 Aansprakelijkheid

Loh schreef in 2019 dat aansprakelijkheid drie zaken omvat. Ten eerste houdt aansprakelijkheid

in dat je verantwoordelijk bent voor iets. Ten tweede is het een normatief concept, dus niet

enkel descriptief en causaal. Ten derde ziet men de persoon in kwestie als een autonoom

persoon die in staat is verantwoordelijkheid op te nemen en de capaciteiten bezit om te kunnen

oordelen en te reflecteren.

Daarnaast stelt Loh dat als het over het subject gaat, er een onderscheid moet gemaakt worden

tussen een individu en een collectief. Indien het subject een individu is, dan zijn er drie vormen

van aansprakelijkheid: enige, persoonlijke en eigen (Loh, 2019). In het andere geval

onderscheidt men gedeeltelijke, volledige of geen aansprakelijkheid (Loh, 2019). Een andere

vorm van aansprakelijkheid, namelijk de ouderlijke aansprakelijkheid, is van toepassing indien

het gaat om minderjarigen (Subramanian, 2017). Dit houdt in dat ouders of voogden

aansprakelijk kunnen worden gesteld, indien de minderjarige in kwestie opzettelijk schade heeft

teweeggebracht aan eigendommen of personen heeft verwond (Subramanian, 2017).

Verder zijn er verschillende autoriteiten die instaan voor de afdwinging van de gevolgen van

aansprakelijkheid. De rechtbank en de rechter zijn voorbeelden van externe autoriteiten (Loh,

2019). Autoriteiten kunnen ook privaat of publiek zijn, deze worden onder andere door de

context en normatieve criteria onderscheiden van elkaar (Loh, 2019). Loh (2019) omschrijft

deze normatieve criteria als voorwaarden waaraan een subject moet voldoen om aansprakelijk

te zijn. Dit kunnen waarden, principes, regels, wetten, etc. zijn.

Tenslotte bestaat er binnen de aansprakelijkheid het principe van de alternatieve

mogelijkheden. Dat principe stelt dat een persoon enkel moreel aansprakelijk is voor zijn/haar

handelingen indien hij/zij op een andere manier had kunnen handelen (Frankfurt, 1969).

Frankfurt weerlegde dit principe in 1969 omdat volgens hem een persoon ook moreel

aansprakelijk kan zijn voor zijn/haar daden, indien hij/zij geen andere keuze had. Een persoon

die een handeling verricht, waarbij hij/zij geen andere keuze had, verricht die handeling immers

niet noodzakelijk omwille van het feit dat er geen alternatieve mogelijkheid was (Frankfurt,

geen andere keuze had. Volgens de onderzoeker moet het principe van de alternatieve

mogelijkheden dan ook vervangen worden door het volgende: een persoon is niet moreel

aansprakelijk voor zijn/haar daden, indien die persoon iets gedaan heeft enkel en alleen omwille

van het feit dat hij/zij niet anders kon.

2.3.4 Privacy

Naast aansprakelijkheid, is ook privacy een belangrijk ethisch aspect. Zo zijn er wereldwijd

honderden wetten die privacy reguleren (Solove, 2008). Privacy is een probleem dat over de

hele wereld van groot belang is (Solove, 2008).

Bovendien steeg de bezorgdheid voor privacy door de ontwikkeling van nieuwe

technologieën (Solove, 2008). Vooral de opkomst van nieuwe informatietechnologieën, zoals

de computer, zorgde ervoor dat privacy wereldwijd uitgroeide tot een probleem (Solove, 2008).

Het inbouwen van waarborgen voor privacy is dan ook van groot belang bij het gebruik van

data bij revolutionaire technologieën, zoals bijvoorbeeld cloud computing, blockchain en big

data (AIR, 2018). Ook andere technologieën zoals persoonlijke of huishoudelijke robots weten

veel informatie over het privéleven van een persoon (Pagallo, 2013). Bij de regulering van

privacy problemen, dient dan ook extra aandacht te zijn voor de mate van autonomie bij

dergelijke robots (Pagallo, 2013). Echter, niet iedereen maakt zich zorgen en sommigen

beweren dat ondanks wat mensen zeggen, hun acties aantonen dat ze eigenlijk helemaal geen

privacy wensen (Solove, 2008).

Uiteindelijk is en blijft privacy een grondrecht dat essentieel is voor vrijheid, democratie,

psychologisch welzijn, individualiteit en creativiteit (Solove, 2008). Tussen de Europese Unie

en de Verenigde Staten is er wel een groot verschil op vlak van privacy regulering (AIR, 2018).

In de Europese Unie is dit een grondrecht, maar in de Verenigde Staten staat het recht op privacy

als consumentenrecht aangeschreven (AIR, 2018).

2.4 Sociale robots, ethiek en rechten

Ook de laatste technologische evolutie, namelijk de digitale revolutie, zorgde voor wijzigingen

in de maatschappij (Russo, 2018). Mensen voeren onder andere steeds vaker met meerdere

robots tegelijk interactie (Fraune et al., 2020). Er zijn hierbij verschillende vormen van

interactie, zoals sociale en functionele (Fraune et al., 2020). In het verloop van deze studie zal

de nadruk liggen op sociale robots en dus op sociale interactie. Robots die ontworpen zijn met

het oog op sociaal contact bevinden zich immers steeds frequenter in het leven van de mens,

waardoor een vraag ontstaat naar een beleid (Darling, 2012). Dit komt onder andere gezien het

feit dat de mens geneigd is menselijke eigenschappen te projecteren op andere objecten om

deze menselijker te doen lijken (Darling, 2012). Dat laatste wordt antropomorfisme genoemd

en betrof oorspronkelijk dieren, maar nu komen dergelijke tendensen ook bij robots voor

(Darling, 2012).

Om de voordelen van robots en artificiële intelligentie optimaal te benutten en risico’s te

beperken, is juridische tussenkomst noodzakelijk (De Bruyne, 2019). Alle nieuwe

technologieën moeten immers veilig zijn (Lin, 2012) en men moet er dus ook op kunnen

vertrouwen dat deze robots op een ethische wijze zullen handelen (Nath & Sahu, 2017).

Bovendien kan een machine wel geprogrammeerd zijn om op een bepaalde wijze te handelen,

maar kan het voorvallen dat in de praktijk de gestelde handelingen niet altijd het gewenste

resultaat opleveren (Sawyer, 2007).

Isaac Asimov had in 1942 een set van regels opgesteld voor robots (Lutz & Tamò, 2015). Ten

eerste mag een robot een mens niet verwonden of, door niets te doen, een mens schade

toebrengen (Lutz & Tamò, 2015). Ten tweede moet een robot de bevelen opvolgen die de mens

hem heeft gegeven, behalve wanneer de bevelen in strijd zijn met de eerste regel (Lutz & Tamò,

2015). Ten derde moet een robot zijn eigen bestaan beschermen, zolang deze bescherming niet

in strijd is met de eerste of de tweede regel (Lutz & Tamò, 2015).

In het vervolg van deze sectie zullen de volgende zaken aan bod komen met betrekking tot

sociale robots en ethiek:

- Morele agenten

- Wetgeving bij sociale robots

- De vergelijking van sociale robots met dieren

- Sociale robots en ouderdom

2.4.1 Morele agenten en ethiek

Ten eerste zijn er binnen de artificiële intelligentie twee soorten morele agenten: impliciet

morele agenten en expliciet morele agenten (Nath & Sahu, 2017). Nath en Sahu (2017)

beschrijven een impliciet moreel agent als een agent die zich ethisch gedraagt omdat het zo

geprogrammeerd is geweest. Deze agent wordt dus beperkt door de ethische principes van de

programmeur (Nath & Sahu, 2017). Een expliciet moreel agent is volgens deze onderzoekers

in staat om, aan de hand van ethische principes, zelf ethische dilemma’s te overwinnen.

Expliciete morele agenten zouden het doel moeten zijn bij de creatie van robots (Anderson &

Anderson, 2007).

Wang en Siau (2019) maken in hun werk een gelijkaardige onderverdeling voor ethische

agenten, namelijk ethische producenten en ethische ontvangers. Een ethisch producent gaat zelf

iets uitvoeren, terwijl een ethisch ontvanger gecommandeerd wordt om iets te doen (Wang &

Siau, 2019). Een voorbeeld van dergelijk ethisch producent is een robot die als assistent

fungeert tijdens een operatie (Wang & Siau, 2019). Een militaire robot die gecommandeerd kan

worden om een aanslag te plegen, is dan een voorbeeld van een ethisch ontvanger (Wang &

Siau, 2019).

Bovendien kunnen criminele daden enkel gepleegd worden door morele agenten (Asaro, 2007).

Dit komt omdat morele agenten beschikken over vrije wil en bewustzijn, enkel dan kan men

zijn. Het enige dat nodig is, is dat de robot correct moreel gedrag vertoont en dit aan de hand

van de gevolgde ethische principes kan gaan rechtvaardigen (Anderson & Anderson, 2007).

Daarnaast is het zo dat indien een robot iets foutief zou uitvoeren, in dit geval dus onethisch

zou handelen, dan zal dit gezien worden als een programmeerfout, terwijl mensen geen

programmeerfouten kunnen bevatten (Nath & Sahu, 2017). Net om die reden schreef Gunkel

reeds in 2012 dat er moet bepaald worden of een robot al dan niet aansprakelijk kan gesteld

worden en verantwoordelijk kan gehouden worden voor een handeling, maar ook vanaf welk

punt dit dan moet gebeuren. De robot bestraffen voor dergelijke foutieve handeling blijft dan

ook een probleem, aangezien een robot wel fysiek aanwezig is, maar het is niet zeker of een tik

geven zou gelden als straf voor de robot en hoe ethisch dit zou zijn (Asaro, 2007).

Verder concludeerden Nath en Sahu in hun onderzoek in 2017 dat een artificieel moreel agent

geen moreel agent kan zijn, net omdat de reden waarom men moreel is enkel toepasbaar is op

subjectieve wezens, niet op een artificieel agent. Ook ethiek bij machines werd om dezelfde

reden weerlegd door hen. Opdat er sprake zou zijn van een ethisch wezen, is de aanwezigheid

van subjectieve gevoelens noodzakelijk, terwijl artificiële morele agenten die niet bezitten

(Nath & Sahu, 2017). Het is dan ook zo dat een moreel agent zijn de mogelijkheid tot het

vertonen van immoreel gedrag vereist (Beavers, 2009). Daardoor is het volgens Beavers (2009)

wenselijk dat robots moreel gedrag enkel simuleren in plaats van echte morele agenten te zijn.

Desondanks schreef Loh in 2019 dat indien er op een dag artificiële agenten zijn die functionele

verantwoordelijkheid toegekend krijgen, hun relatie met hun menselijke ‘ouders’ vergelijkbaar

zou zijn met de relatie van bijna meerderjarige kinderen met hun ouders. Ook Asaro (2007)

maakt de vergelijking van minderjarigen en robots. Minderjarigen worden namelijk als

quasi-personen gezien en beschikken dus niet over de volledige rechten die volwassenen hebben

(Asaro, 2007). Dit betekent dat in het geval van een fout die de robot zou veroorzaken, de

menselijke ‘ouders’ van de robot altijd, al dan niet gedeeltelijk, aansprakelijk zullen zijn voor

de daden van de robot (Loh, 2019). Een quasi-persoon beschikt namelijk over verminderde

aansprakelijkheid (Asaro, 2007).

Ten slotte dient een sociale robot onder andere morele competenties te hebben, opdat deze

geschikt zou zijn voor sociale interactie met mensen (Malle & Scheutz, 2014). Enkele

voorbeelden van deze competenties zijn normen, morele communicatie en morele

besluitvorming (Malle & Scheutz, 2014). Mensen bezitten deze morele competenties niet van

bij de geboorte, maar leren dit vanaf de kindertijd (Malle & Scheutz, 2014). Robots zullen, net

zoals kinderen, deze competenties moeten leren, stellen Malle en Scheutz (2014). De

onderzoekers wijzen er echter wel op dat het nog onzeker is hoe goed robots dergelijke

competenties kunnen leren. Echter, het gebruik van sociale signalen zou een robot in staat

stellen om op een snelle manier bij te leren (de Greeff & Belpaeme, 2015). Dit wordt ook wel

sociaal leren genoemd (de Greeff & Belpaeme, 2015).

2.4.2 Robotethiek en wetgeving

Naast moraliteit, kan er ook verder worden ingegaan op robotethiek en de wetgeving daarrond.

Robotethiek is namelijk een relatief jonge filosofische discipline (Loh, 2019). Zoals reeds in

sectie 2.2.1 werd aangehaald, zijn alle robots machines. Machine ethiek focust zich op de

moraliteit van machines (Bendel, 2013). Robotethiek is dan ook een subcategorie van de

machine ethiek (Loh, 2019). De Artificiële Intelligentie Impact Assessment (AIIA) bevat een

plan van acht stappen, waarmee bedrijven inzicht kunnen verwerven over welke juridische en

ethische normen van belang zijn bij het creëren van AI-systemen en slimme robots (AIR, 2018).

Dit stappenplan wordt voorafgegaan door de Gedragscode Artificiële Intelligentie (GAI), een

twintigtal punten waaraan de ontwikkeling, maar ook het gebruik, van de kunstmatige

intelligentie moet voldoen (AIR, 2018). De GAI vormt dus de basis voor het raamwerk onder

AIIA. Ook bij de implementatie van AI kan de AIIA helpen bij het maken van beslissingen en

keuzes door de motieven die aan de basis liggen, te verhelderen (AIR, 2018). AIIA is nog niet

verplicht, maar kan wel ten goede komen bij rechtszaken over onder andere de

aansprakelijkheid van slimme robots of de verantwoordelijke bij bepaalde gebeurtenissen (AIR,

voornamelijk verder op veiligheidsvereisten van industriële, zorg- en medische robots (BSI,

2016). De standaard is voornamelijk bedoeld voor ontwerpers en managers die betrokken zijn

bij het ontwerp van robots, maar ook de gebruikers van het eindproduct zullen hier baat bij

hebben indien de richtlijnen effectief werden nageleefd (BSI, 2016).

Bovendien is in de medische en educatieve sector het potentieel van sociale robots hoog en zijn

dit tevens de sectoren waar ethiek van groot belang is (Senft, Lemaignan, Baxter, Bartlett, &

Belpaeme, 2019). Een sociale robot wordt bovendien beter geaccepteerd als teamlid, dan een

menselijke collega, wat leidt tot een stijging van de productiviteit (Vänni & Korpela, 2015).

Ook Senft et al. (2019) schrijven in hun werk dat de menselijke productiviteit zou stijgen. Dit

zou volgens de onderzoekers omwille van de autonomie van sociale robots zijn, maar ook

doordat fysische en cognitieve taken zouden kunnen overgelaten worden aan de robot. Daarbij

benadrukken de auteurs dat de sectoren waar sociale robots veel potentieel hebben, ook het

meest risico lopen op slechte functionerende autonome systemen. Dat laatste wordt versterkt

door ethische bezwaren (Senft et al., 2019). Mensen dienen immers deze autonome systemen

te vertrouwen (Salem, Lakatos, Amirabdollahian, & Dautenhahn, 2015). Dit vertrouwen houdt

in dat mensen de informatie die de sociale robot verschaft aanvaarden en de instructies van de

robot volgen (Salem et al., 2015). Er is geen eenduidige definitie van vertrouwen, maar

betrouwbaarheid en voorspelbaarheid zijn begrippen die vaak voorkomen bij de invulling van

het begrip. Daarom is het van belang dat robots via hun sociale handelingen een goede indruk

maken bij de mens, zodat mensen hen als betrouwbaar en veilig zien (Salem et al., 2015). Indien

dat niet het geval is, zouden mensen bijvoorbeeld de aanbevelingen van de robot weigeren op

te volgen (Salem et al., 2015). Echter, bij te veel vertrouwen in de sociale robot kunnen mensen

storingen of foutieve handelingen negeren, wat tevens ongewenst is (Salem et al., 2015). De

juiste balans tussen autonomie van een sociale robot en menselijke controle is cruciaal op

ethisch vlak, maar tevens een van de grootste uitdagingen (Senft et al., 2019). Salem et al.

(2015) stellen in hun onderzoek dan ook de vraag of opleidingen en licenties niet verplicht

zouden moeten zijn, aangezien de doelgroep van sociale robots doorgaans niet-deskundige

gebruikers zijn.

Ook schreef Asaro in 2007 dat de wettelijke verantwoordelijkheid voor handelingen van de

robot bij de persoon ligt die de robot toestemming geeft om namens hem te handelen, maar dit

inschatten of de gevolgen van de actie schade zullen veroorzaken of niet (Gelin, 2015). Indien

deze inschatting zou overgelaten worden aan de robot, dan moet de robot de

voorgeprogrammeerde ethische principes van de fabrikant volgen. Bijgevolg moet de gebruiker

zich aanpassen aan de ethiek van een ander (Gelin, 2015). Bijleren over de robot is

noodzakelijk, opdat de mens de robot zou kunnen besturen en niet omgekeerd (Gelin, 2015).

Echter, op vlak van aansprakelijkheid en verantwoordelijkheid bij schade toegebracht

door kunstmatige intelligente applicaties en robots, ontbreekt er een wettelijke regelgeving.

Daarom kan er gekeken worden naar Boek 6 Titel 3 Burgerlijk Wetboek inzake Onrechtmatige

daad (AIR, 2018). Hierbij is Artikel 6:162 BW van belang die zou kunnen toegepast worden in

het geval er schade is veroorzaakt door een robot en luidt als volgt:

“1. Hij die jegens een ander een onrechtmatige daad pleegt, welke hem kan worden

toegerekend, is verplicht de schade die de ander dientengevolge lijdt, te vergoeden.

2. Als onrechtmatige daad worden aangemerkt een inbreuk op een recht en een doen of

nalaten in strijd met een wettelijke plicht of met hetgeen volgens ongeschreven recht in

het maatschappelijk verkeer betaamt, een en ander behoudens de aanwezigheid van een

rechtvaardigingsgrond.

3. Een onrechtmatige daad kan aan de dader worden toegerekend, indien zij te wijten

is aan zijn schuld of aan een oorzaak.” (AIR, 2018).

Verder heeft een wetgeving ook nadelen. Zo kan het onterecht de fabrikant van de robot

vrijwaren van eventuele schuld voor bijvoorbeeld een foutief ontwerp of een programmeerfout

(Asaro, 2007). Daarnaast kunnen de eigenaars van robots door dergelijke wetgeving afgeschrikt

worden doordat het hen een last oplegt, waardoor de wenselijkheid voor de adoptie van robots

vermindert (Asaro, 2007). Darling schreef in 2012 dan ook dat een wetgeving voor sociale

robots pas wenselijk is als de meerderheid van de maatschappij hierom vraagt. Een wetgeving

toont namelijk aan welke normen en waarden mensen wensen af te dwingen binnen een

maatschappij (Luhmann & Kastner, 2004).

reeds gedefinieerd. Een toevoeging aan deze definitie is dat de robot ook op realistische wijze

moet kunnen reageren op mishandeling (Darling, 2012). Naast het definiëren van sociale robots,

zou er ook een afbakening moeten gebeuren van de term ‘mishandeling’ (Darling, 2012). Dit

vereist echter nog verder onderzoek in de toekomst (Darling, 2012).

2.4.3 Zijn sociale robots dieren?

Indien robots ethische agenten zouden worden, dan dient er nagedacht te worden over het al

dan niet toe verlenen van rechten aan robots, morele verplichtingen van de mens tegenover deze

robots, vrijheid van de robots, etc. (Nath & Sahu, 2017). Rechten voor sociale robots kunnen

op allerlei manieren tot stand komen. Saoedi-Arabië gaf de robot Sophia bijvoorbeeld

staatsburgerschap (De Bruyne, 2019). Wie staatsburgerschap bezit geniet van bepaalde rechten

en komt zijn/haar plichten na (Marx & Tiefensee, 2020).

Echter, Marx en Tiefensee (2015) vinden dat huisdieren geen staatsburgerschap dienen te

krijgen. Hierdoor zouden de morele kwaliteiten van de dieren verkeerd ingeschat worden en

ontstaat er het risico dat ze onrechtvaardig behandeld zouden worden (Marx & Tiefensee,

2020). Desondanks, worden dieren wel reeds door de wet beschermd. Zo zouden ook sociale

robots beschermd kunnen worden (Darling, 2012).

Deze vergelijking van sociale robots met dieren is iets dat algemeen voorkomt (Johnson

& Verdicchio, 2018). Mensen hebben bovendien de neiging om robots te zien als dieren (Marx

& Tiefensee, 2020). Dit wordt ook wel ‘zoomorfisme’ genoemd, waarbij dierlijke kenmerken

worden toegeschreven aan objecten en mensen (Sandry, 2015). Zelfs robots die niet ontworpen

zijn om er dierlijk uit te zien, veroorzaken het effect van ‘zoomorfisme’ bij de mens (Sandry,

2015).

Volgens Darling (2012) zijn de redenen waarom men robots zou beschermen niet volledig

hetzelfde als bij dieren, maar er zijn wel raakpunten op psychologisch en filosofisch vlak. Een

filosofisch argument is bijvoorbeeld de morele verplichting om leed en pijn bij levende wezens

te voorkomen (Darling, 2012). Daarnaast is het beschermen van dieren ook een soort van

bescherming van onze eigen emoties (Darling, 2012). Er zijn ook andere gelijkenissen tussen

en worden ze zelfs als minderwaardig gezien, doordat ze onder andere geen of bijna geen

waarde en morele status hebben (Johnson & Verdicchio, 2018). Onafhankelijk van welke

argumenten gehanteerd worden, kan de regulering met betrekking tot het beschermen van

robots op dezelfde manier gestructureerd worden als de wetgeving tegen dierenmishandeling,

stelt Darling (2012).

Echter, Johnson en Verdicchio (2018) beweren in hun onderzoek dat de vergelijking van robots

met dieren misleidend is, omdat er nog geen zekerheid is over hoe sociale robots dienen

behandeld te worden. Volgens hen mag het feit dat dieren levende organismen zijn en robots

dit niet zijn, niet uit het oog verloren worden. Als het gaat over de morele status, wettelijke

aansprakelijkheid en de impact op hoe mensen andere mensen behandelen, is de vergelijking

van robots met dieren dus foutief volgens Johnson en Verdicchio (2018).

Tenslotte zou volgens Kant de manier waarop mensen dieren behandelen, een impact hebben

op hoe mensen elkaar behandelen (Johnson & Verdicchio, 2018). Een persoon zijn omgang met

dieren zegt namelijk iets over die persoon zijn zedelijkheid (Johnson & Verdicchio, 2018).

Echter, Johnson en Verdicchio (2018) schrijven dat er geen bewijs is dat de manier waarop men

dieren behandelt een invloed zou hebben op hoe men mensen gaat behandelen. Volgens de

onderzoekers wordt deze filosofie dan ook onterecht toegepast op robots. Indien dergelijk effect

toch zou bestaan, dan zijn robots niet te vergelijken met dieren (Johnson & Verdicchio, 2018).

Dieren lijden namelijk bij mishandeling, terwijl dit niet het geval is bij robots aangezien deze

niet gevoelig zijn (Johnson & Verdicchio, 2018). In staat zijn om te lijden, is een belangrijk

ethisch en moreel argument (Bendel, 2013). Johnson en Verdicchio (2018) stellen het dan ook

in vraag waarom men robots gevoelig zou maken, aangezien deze vooral ontwikkeld worden

om mensen te helpen of te begeleiden, bijvoorbeeld bij ouderen.

maatschappij en de opkomst van sociale robots dat ouderen steeds vaker begeleid worden door

dergelijke robots (Gelin, 2015). Een toepassing van sociale assistentie robots bij residenties van

ouderen, werd reeds besproken in sectie 2.2.4. Sociale robots kunnen echter ook ingezet worden

bij ouderen thuis, waarmee eenzaamheid en de nood aan begeleiding gedeeltelijk verholpen

worden (Gelin, 2015). Gelin schreef in 2015 dat het oplossen van deze problemen, geen nieuwe

problemen mogen veroorzaken, zoals op ethisch vlak.

Een eerste bedenking die Gelin (2015) aanhaalt, is of het al dan niet ethisch is om ouderen

alleen te laten met een robot. De onderzoeker stelt dat zolang het niet haalbaar is voor

familieleden om voldoende te zorgen voor de ouderen, een sociale robot een goede oplossing

is om hen autonomie en veiligheid te bezorgen. Een tweede en zeer cruciaal ethisch aspect is

dat er sprake is van bedrog, indien de fabrikant beweert dat de robot emoties heeft (Gelin, 2015).

De ouderen dienen afstand te houden van een robot op emotioneel vlak (Gelin, 2015). Mensen

herkennen mensachtige verschijningen en mensachtige stemmen (Ishiguro, 2015). Hierdoor is

het van belang om de sociale robot voldoende te differentiëren van een mens, zodat de

emotionele afstand bewaard kan blijven (Gelin, 2015). Daarnaast kan de gebruiker ook bijleren

over de robot, zodat de gebruiker zijn/haar gevoelens naar de robot toe kan relativeren, stelt

Gelin (2015).

Opdat sociale robots ethisch zouden zijn, moeten ouderen deze interactie ook willen accepteren

(Frennert & Östlund, 2014). Enkele factoren die een rol spelen bij de acceptatie van een sociale

robot door ouderen, zijn onder andere de acceptatie door anderen, juridische en sociaal-ethische

factoren (Frennert & Östlund, 2014). Ook menselijke en/of dierlijke kenmerken, die

respectievelijk zorgen voor antropomorfisme en/of ‘zoomorfisme’, dragen bij tot de acceptatie

van sociale robots (Sandry, 2015). Bovendien hebben sociale assistentie robots met dierlijke

kenmerken beduidend gunstigere resultaten bij de preventie van mentale problemen en het

verbeteren van de algehele conditie van ouderen met neurodegeneratieve aandoeningen (Barata,

2019).

Tenslotte stelde Gelin (2015) in zijn werk de vraag wie aansprakelijk is, indien een robot

iemand schade of leed bezorgt. Terwijl Asaro in 2007 schreef dat de verantwoordelijkheid voor

hem te handelen, is ook de fabrikant medeverantwoordelijk volgens Gelin (2015). De fabrikant

moet er namelijk voor zorgen dat de robot correct werkt, het is en blijft immers een toestel

(Gelin, 2015). De AI-ontwikkelaar kan dan ook in sommige gevallen risicoaansprakelijk zijn,

indien deze op de hoogte was dat de software schade zou kunnen veroorzaken, maar toch op de

markt heeft gebracht (AIR, 2018).

2.5 Onderzoek tot op heden

2.5.1 SLR-protocol

Er is veel onderzoek gaande omtrent het creëren van artificiële systemen die door mensen

als sociale entiteiten of agenten zouden gezien worden (Jones, Lawson, & Mills, 2008).

Sociale robots zijn dan ook het type robots waarbij er hoge verwachtingen zijn dat ze over

enkele jaren in het alledaagse leven van de mens aanwezig zullen zijn (Jones et al., 2008).

Zoals reeds bleek uit de literatuurstudie tot nu toe, ontstaan er hierdoor vaak juridische en

ethische kwesties. Hiervan zijn sommige reeds grondig onderzocht, terwijl andere nog

maar net in de onderzoekswereld aan aandacht winnen. Deze kwesties zullen nader

besproken worden op basis van reeds verrichte studies. Onderstaande tabel geeft alvast

het SLR-protocol weer dat binnen dit onderzoek werd toegepast.

Tabel 2: SLR-protocol

Protocol elementen

Binnen dit onderzoek

Onderzoeksvraag

Wat is de stand van huidig onderzoek naar ethiek en rechten

van sociale robots?

Doorzochte bronnen

Web of Science, Google Scholar, Scopus

Zoektermen

Social robot, ethics, morality, law, responsibility, animals,

humanoid robots, ethical, autism, elderly people, SAR, HRI

Zoekstrategie

Zoektermen die voorkwamen in de titel, kernwoorden of

abstract. Geen beperkingen op vlak van onderwerp of

publicatiedatum.

Inclusiecriteria

Geschreven in het Nederlands of Engels

Exclusiecriteria

Artikels zonder volledige toegang, artikels in een andere taal

dan Engels of Nederlands

Kwaliteitscriteria

Gepubliceerd in peer-reviewed tijdschrift of conferentie

Om huidige studies naar ethiek en rechten van sociale robots te verzamelen, werd er

gebruik gemaakt van verschillende databases. Deze waren Web of Science, Google

Scholar en Scopus. De zoekopdracht omvatte combinaties van de volgende kernwoorden:

“social robot”, “ethics”, “morality”, “law”, “responsibility”, “liability”, “animals”,

“humanoid robots”, “ethical”, “autism”, “elderly people”, “HRI” en “SAR”. Indien de

zoektermen voorkwamen in de titel, kernwoorden of abstract, werd de abstract gelezen

om de bruikbaarheid van de bron na te gaan. Er waren hierbij geen beperkingen op vlak

reviewed tijdschriften of conferenties, in het Nederlands of Engels, werden geselecteerd

uit de zoekresultaten.

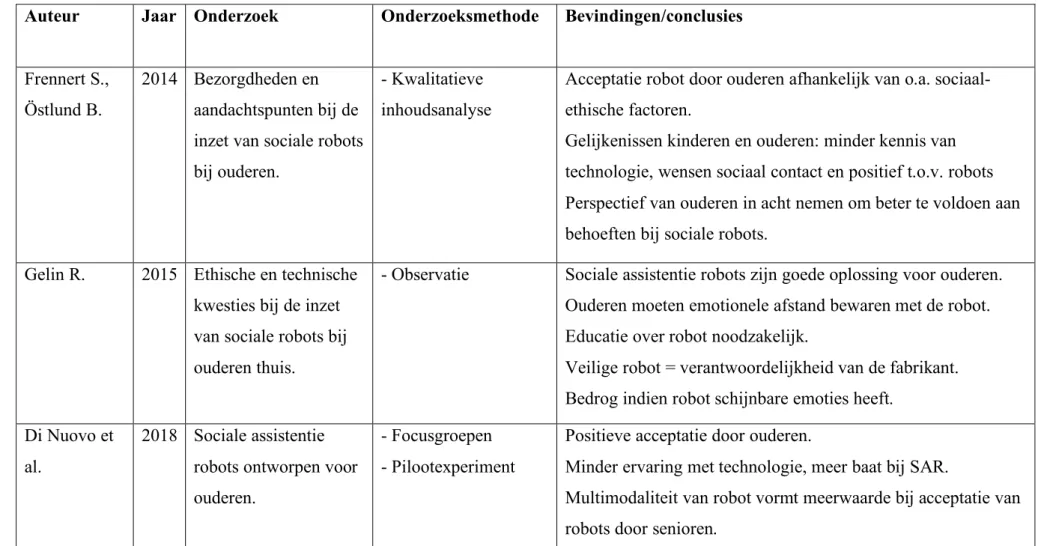

Tabel 3: Overzicht bestaande studies