Een hoogperformant

Teraflops-computersysteem

Impulsproject Zware Apparatuur, voortgangsrapport

12/2006

De Stuurgroep HPC

1

Inleiding

Het project getiteld “Een hoogperformant Teraflops-computersysteem” dat betoelaagd wordt in het kader van de impulsactie Zware Apparatuur wordt gedragen door 18 ver-schillende onderzoeksgroepen uit zeer verver-schillende wetenschappelijke discipline’s. Op de oorspronkelijke aanvraag werden, wegens plaatsgebrek, enkel de volgende promoto-ren vermeld: Stefaan Poedts, Dirk Roose, Minh Tho Nguyen, Jos Vander Sloten, Paul Van Houtte, Michel Rots en Dirk Van den Poel (UGent). De bindende factor tussen de onderzoekers uit de 18 groepen is de grote nood aan rekenkracht en het gebruik van de-zelfde of zeer gelijkaardige rekentechnieken en algoritmen in nochtans zeer uiteenlopende toepassingsdomeinen.

Op 4 maart 2004 werd door het GeBu reeds een budget van 500 Keuro beschikbaar gesteld voor High Performance Computing (dit op voorstel van de ICTS-raad, en in aan-wezigheid van de voorzitter van de ICTS-raad A. Van de Capelle op het GeBu besproken, nadat hierop werd aangedrongen door S. Poedts en D. Roose in naam van de potenti¨ele ‘High Performance Computing’ (HPC) gebruikers). Voor het beheer van dit bedrag werd een Stuurgroep HPC opgericht. Vervolgens werd de hernieuwde aanvraag voor ‘Impulsfi-nanciering Zware Apparatuur’ (oproep 2004) ingediend en voor fi‘Impulsfi-nanciering weerhouden. Volgens de Implementatieclausule is er voor dit project een aparte stuurgroep met daarin de (co-)promotoren van dit Impulsproject (zie hoger) en R. Florizoone (Ludit). Aangezien er nogal wat overlap was tussen de twee stuurgroepen en beide budgetten uiteraard voor dezelfde HPC-infrastructuur worden aangewend, hebben deze twee stuurgroepen altijd samen vergaderd. Zoals vermeld in het verslag van de vergadering van 14 april 2005, was het de bedoeling om te komen tot ´e´en stuurgroep HPC, teneinde het overzicht te behouden. Dit mede op vraag van de Dienst Onderzoeksco¨ordinatie.

1.1

De ‘stuurgroep HPC’

In de vergadering van 17 november 2005 werd beslist om ´e´en stuurgroep voor het beheer van de HPC-infrastructuur op te richten. Deze ‘Stuurgroep HPC’ heeft momenteel de volgende samenstelling:

• de twee voorzitters van de vroegere stuurgroepen, nl. Prof. D. Roose en Prof. S. Poedts;

• twee personen van LUDIT, waar de HPC-apparatuur gehuisvest is, nl. Prof. A.-M. De Meyer en de heer R. Florizoone;

• vertegenwoordigers van de grote gebruikersgroepen, nl. Prof. E. Nies (fac. Wet., dept. Chemie), Prof. J. Monbaliu (fac. Ing.wet., dept. Burgerlijke Bouwkunde); • als ‘technische experten’ werden vertegenwoordigers van andere grote

gebruikers-groepen en LUDIT toegevoegd, nl. Dr. B. Tijskens (fac. Bio-ing., dept. Biosyste-men), ir. P. De Mazi`ere (fac. Geneeskunde, dept. Neurowetenschappen), Lic. D. Kimpe (fac. Wet., dept. Wiskunde), Lic. W. Obbels (LUDIT) en Dr. J. De Laet (LUDIT).

Deze stuurgroep wordt voorgezeten door S. Poedts (promotor van het Impulsproject Zware Apparatuur i.v.m. HPC). Deze stuurgroep richt zich enkel op de technische installatie en het beheer van de infrastructuur, terwijl de oorspronkelijke promotoren en de hoofden van de deelnemende groepen onverminderd blijven instaan voor de wetenschappelijke aspecten en verantwoordelijkheden van dit project.

De doelstellingen van de stuurgroep HPC zijn het verlagen van de drempel voor HPC, het aanmoedigen van het gebruik van de HPC-infrastructur om zo het wetenschappelijk onderzoek aan de K.U.Leuven (en daarbuiten) te stimuleren en op hoger niveau brengen, en kosten te besparen door een centraal beheer (bv. ´e´en operator i.p.v. ´e´en operator per onderzoeksgroep/departement, ´e´en koelingsinstallatie, ´e´en backup-systeem, enz.) en gerichte en gefaseerde aankopen (waarbij de eisen/wensen van de HPC gebruikers centraal staan).

2

Opstartverslag

2.1

Budget en planning

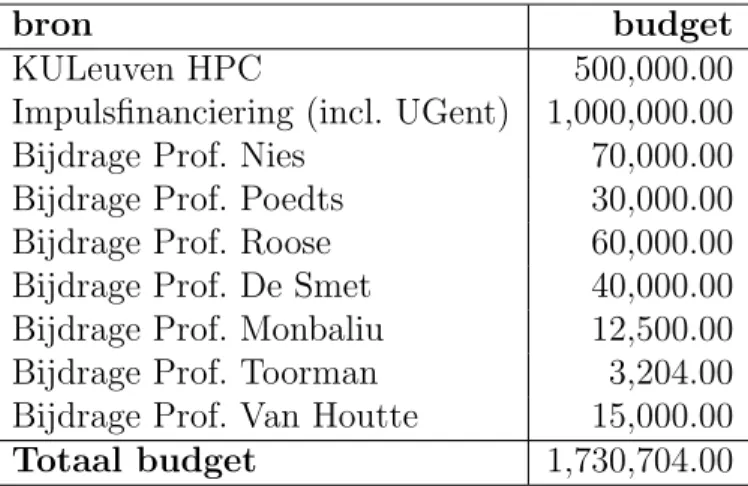

Zoals hierboven vermeld, werden de stuurgroep van dit impulsproject samengevoegd met de stuurgroep rond de K.U.Leuven HPC infrastructuur in de ‘Stuurgroep HPC’. Daardoor bestond het initi¨ele budget voor de HPC infrastructuur uit 500 Keuro van de K.U.Leuven en 1 Meuro van het impulsproject (inclusief 100 Keuro van het gedeelte UGent van de impulsactie Zware Apparatuur). Bovendien werden de onderzoeksgroepen die van de HPC infrastructuur gebruik maken, aangemoedigd om mee te investeren in de infrastructuur via de (eventueel nog te verwerven) uitrustingskredieten op hun wetenschappelijke projecten. Tot dusver gingen al 7 groepen in op dit voorstel met een totale investering van 230,704.00 euro. Het totale budget voor de HPC infrastructuur komt daardoor op 1,730,704.00 euro. In Tabel 1 wordt een overzicht gegeven van de samenstelling van dit HPC budget.

Reeds bij de aanvraag werd gepland om de HPC-apparatuur in verschillende modu-les gefaseerd aan te kopen zodat het budget optimaal besteed wordt en zoveel mogelijk rekencapaciteit oplevert. Optimalisatiestudies wezen uit dat, gezien de wet van Moore, in het eerste jaar best 26% van de CPUs kan gekocht worden. Door in het tweede en derde jaar dan telkens 37% van de CPUs bij te kopen neemt de cumulatieve capaciteit over een gebruiksperiode van 6 jaar met meer dan 30% toe t.o.v. de aanschaf van het hele systeem ineens in het eerste jaar. Er werd voorzien dat na 3 jaar een totale theoretische piekcapaciteit van minstens 1 Teraflops behaald kon worden. Het extra budget van 500 Keuro in de opstartfase liet ons echter toe veel beter te doen dan dat. Het principe van gefaseerde aankoop in modules werd uiteraard behouden.

bron budget KULeuven HPC 500,000.00 Impulsfinanciering (incl. UGent) 1,000,000.00 Bijdrage Prof. Nies 70,000.00 Bijdrage Prof. Poedts 30,000.00 Bijdrage Prof. Roose 60,000.00 Bijdrage Prof. De Smet 40,000.00 Bijdrage Prof. Monbaliu 12,500.00 Bijdrage Prof. Toorman 3,204.00 Bijdrage Prof. Van Houtte 15,000.00 Totaal budget 1,730,704.00

Tabel 1: Overzicht van de samenstelling van het huidige totale budget voor HPC infra-structuur.

2.2

De beginconfiguratie

Op 4 mei 2005 werd de nieuwe HPC-infrastructuur (een ‘computer cluster’) ge¨ınstalleerd in Ludit. De toen reeds bestaande cluster van het Centrum voor Plasma-Astrofysica werd in de nieuwe cluster ge¨ıntegreerd zodat het nieuwe HPC-systeem (na volledige installatie) bestond uit 177 ‘reken-knopen’ met telkens minstens 2 processoren (AMD Opteron) en 2 GB RAM geheugen. E´en van de 177 knopen bevatte 8 processoren, een andere knoop was een zgn. ‘dual-core 4-way’, en nog drie andere knopen waren ‘dual core dual servers’. De grote meerderheid van de nieuwe nodes werden onderling verbonden met het zeer snelle Infiniband interconnectie netwerk, waardoor sommige berekeningen die uitgevoerd wor-den op meerdere nodes veel sneller uitgevoerd kunnen worwor-den. Bovendien bevatten acht knopen 16 GB RAM geheugen zodat het volledige systeem in totaal 372 rekenprocessoren bezat en meer dan 500 GB RAM geheugen. Dit HPC systeem had een theoretische piek-performantie van 1,8 Tflops (in dubbele precisie, 3,6 Tflops in ’single precission’) en een totale opslagcapaciteit van meer dan 30 TB.

We merken hierbij op dat in de aanvraag van de impulsfinanciering een systeem van ‘minstens 1 Tflops’ werd voorzien met ‘minstens 500 GB RAM en ‘minstens 2 TB’ op-slagcapaciteit. De initi¨ele configuratie voldeed dus al ruimschoots aan de minimum eisen die vooropgesteld werden.

3

Uitbreidingen van de HPC infrastructuur

3.1

Fase A: uitbreiding van de opslagcapaciteit

In April 2006 werd de cluster uitgebreid met extra opslagcapaciteit. Op vraag van de gebruikers van de HPC-infrastructuur werden twee extra ‘lustre storage nodes’ aangekocht voor een totaal van 5 TB extra schijfruimte, met infiniband interconnect. Bovendien werden 8 extra ‘high memory’ compute nodes aangekocht: 4 Opteron252 nodes, en 4 ‘dual core Opteron270’ nodes (zodat we nu een aantal zeer snelle processoren hebben, en een aantal extra SMP servers met veel geheugen) en ook een extra externe RAID unit met een capaciteit van 4 TB, om de NFS server te ontlasten.

3.2

Fase B: uitbreiding van de rekenkracht

In September 2006 werd de cluster uitgebreid met 120 extra rekennodes. Het betreft zgn. ‘two way dual core AMD Opteron275’ nodes (dus in praktijk met 4 ‘compute cores’ of rekenkernen per node) met elk 4 GB RAM geheugen en onderling verbonden met het zeer snelle ‘Infiniband interconnect’.

De huidige HPC-infrastructuur bestaat dus uit 297 nodes met in totaal 852 AMD Opteron cores waarvan er 752 via een snelle Infiniband switch met elkaar verbonden zijn. Deze cluster heeft 1.14 TB RAM geheugen en een theoretisch piek-performantie van ongeveer 4 Tflops (3912 Gflops)!

Merk op dat in top 500 van de meest perfomante HPC-systemen, de eerste plaats mo-menteel wordt ingenomen door een 280.6 Tflops systeem, terwijl het systeem op de vijfhon-derdste plaats een performantie heeft van 2.737 Tflops. In de vorige lijst, van 6 maanden geleden, had het systeem op de 500ste plaats nog een performantie van 2.026 Tflops. Toen werd de 100ste plaats ingenomen door een systeem van 4.71 Tflops (vergelijkbaar met ons huidige systeem). In de huidige Top500-lijst heeft het systeem op de 100ste plaats echter al een performantie van 6.65 Tflops (sie http://www.top500.org/lists/2006/11/highlights). Het blijft dus nodig om nieuwe investeringen te doen om niet opnieuw achterop te geraken in vergelijking met andere universiteiten en onderzoeksinstellingen.

4

Gebruik van de HPC infrastructuur

4.1

Politiek in verband met gebruik: ‘fair share’

Vermits de huidige HPC-infrastructuur gedeeltelijk gefinancierd werd met K.U.Leuven-middelen (500 Keuro), kunnen alle onderzoekers van de K.U.Leuven de HPC-infrastructuur gebruiken. De stuurgroep HPC heeft een model uitgewerkt om de beschikbare rekenkracht eerlijk te verdelen onder de gebruikers. Dit ‘fair share’ model houdt in dat elke groep een zeker percentage van de totale cpu-tijd krijgt (indien die groep hiertoe voldoende jobs submit), volgens een vastgelegde verdeelsleutel. Deze verdeelsleutel houdt onder meer rekening met het al dan niet deelnemen van de onderzoeksgroep aan het impulsproject en met eventuele bijkomende investeringen in de infrastructuur door de gebruikersgroe-pen zelf (zie hoger bij samenstelling HPC-budget). Merk op dat, telkens wanneer er gebruikersgroepen bijkomen (al dan niet met bijkomende eigen investeringen), het ‘fair share’-percentage van de andere groepen uiteraard zakt. Bovendien wordt eventueel ex-tra beschikbare cpu-tijd volgens dezelfde sleutel verdeeld tussen onderzoeksgroepen die (tijdelijk) meer rekenkracht kunnen gebruiken.

Dit model is als volgt ge¨ımplementeerd met behulp van de Maui scheduler: wanneer iemand van een groep een job submit, wordt deze job in de job ‘queue’ geplaatst met een prioriteit die afhangt van het relatief (t.o.v. het fair-share percentage voor de groep) cpu-gebruik van die groep in de voorbije 4 weken (dus groepen die in de voorbije 4 weken relatief minder intensief gebruik gemaakt hebben van het cluster zullen hun jobs sneller zien starten). Een tweede factor die de beginprioriteit van een job bepaalt is het aantal cpu’s dat de job nodig heeft (hiermee wordt echt parallel werk gestimuleerd). Vanaf het moment dat een job in de job queue zit, zal de prioriteit ervan bovendien stijgen naarmate de job langer in de queue zit (dit zorgt ervoor dat elke job uiteindelijk zal

uitgevoerd worden). Pas wanneer de computercluster langere tijd op 100% zal draaien, zullen we deze implementatie echt kunnen evalueren en bv. nagaan of iedere groep die dit wenst gemiddeld zijn toegekend fair-share percentage krijgt, en of de eventuele cpu-tijd op overschot (van andere groepen) op dezelfde proportionele manier verdeeld wordt tussen groepen die meer rekencapaciteit nodig hebben. Indien nodig zullen de parameters dan bijgesteld worden en eventueel zullen er bijkomende parameters ingevoerd worden.

Toekenning van personen aan ‘groepen’ gebeurt nu automatisch (via LDAP, gebaseerd op het KULeuven organigram en de personeelsnummers van de gebruikers). Dit systeem maakt ook het aanvragen en activeren van accounts makkelijk (semi-automatisch), zodat de instapdrempel vrij laag is. Maar de vraag is of dit systeem altijd optimaal is. Sommige departementen zijn opgedeeld in grote afdelingen of onderzoeksgroepen, andere in kleine. Bovendien wijzigt het organigram soms. Hoe kan/moet dit weerspiegeld worden in de verdeelsleutel? Dit is echter een vraag die zich pas echt zal stellen wanneer de HPC cluster voor langere tijd op 100% draait.

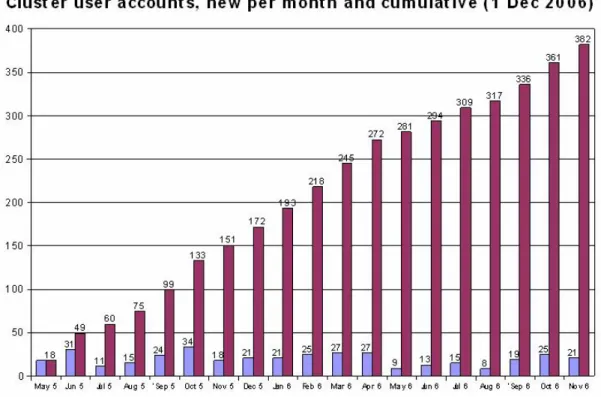

Figuur 1: Evolutie van het totaal aantal user accounts aangemaakt voor de HPC-infrastructuur sinds de cluster in mei 2005 in gebruik genomen werd.

4.2

Evolutie van het gebruik van de HPC-infrastructuur

In het oorspronkelijke plan van de aanvraag voor impulsfinanciering voor zware appa-ratuur werd voorzien dat de HPC-infrastructuur pas in het derde jaar voor de andere K.U.Leuven onderzoekers ter beschikking zou komen. Het bleek al meteen dat de gro-te nood aan rekenkracht niet beperkt was tot de 18 groepen in dit project. Wegens de K.U.Leuven bijdrage van 500 Keuro aan het HPC-budget, werd de infrastructuur echter vanaf het begin voor iedere K.U.Leuven onderzoeker ter beschikking gesteld.

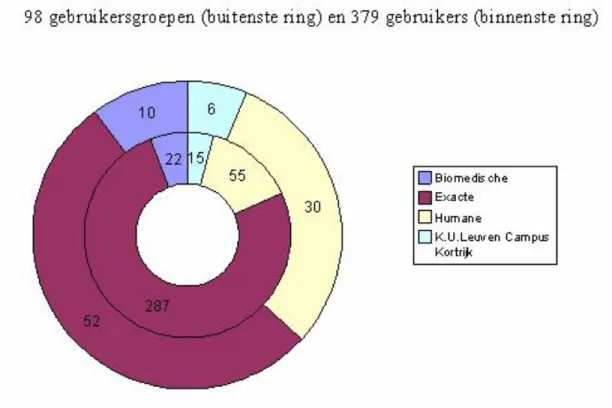

Figuur 2: Voorstelling van de herkomst van de 379(!) K.U.Leuven gebruikers (binnen-ste ring) en van de 98 onderzoeksgroepen (buiten(binnen-ste ring) die momenteel op de clu(binnen-ster rekenen.

4.2.1 Overzicht van de gebruikers

Momenteel maken minstens 380 onderzoekers gebruik van de HPC-infrastructuur (er werden reeds 382 user accounts aangemaakt, incl. 3 accounts voor centrale diensten (o.a. Libis)). De evolutie van het totaal aantal gebruikers van de HPC-infrastructuur sinds de cluster in mei 2005 in gebruik genomen werd, wordt weergegeven in Fig. 1.

De 379 K.U.Leuven onderzoekers komen uit maar liefst 98 (!) verschillende onder-zoeksgroepen van zowel exacte wetenschappen (52 onderonder-zoeksgroepen, 287 gebruikers!), humane wetenschappen (30 onderzoeksgroepen met in totaal 55 gebruikers), als biomedi-sche wetenschappen (10 onderzoeksgroepen met in totaal 22 gebruikers) wetenschappen, en Kulak (6 onderzoeksgroepen met in totaal 15 gebruikers), zie de samenvatting in Fig. 2. Bovendien is er ook ´e´en account van Prof. Dirk Van den Poel (UGent).

4.2.2 Overzicht van het gebruik

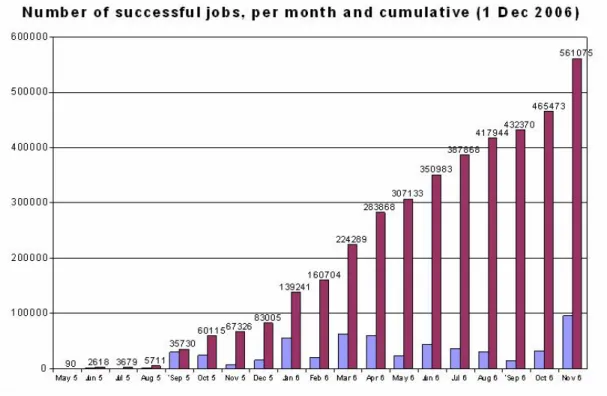

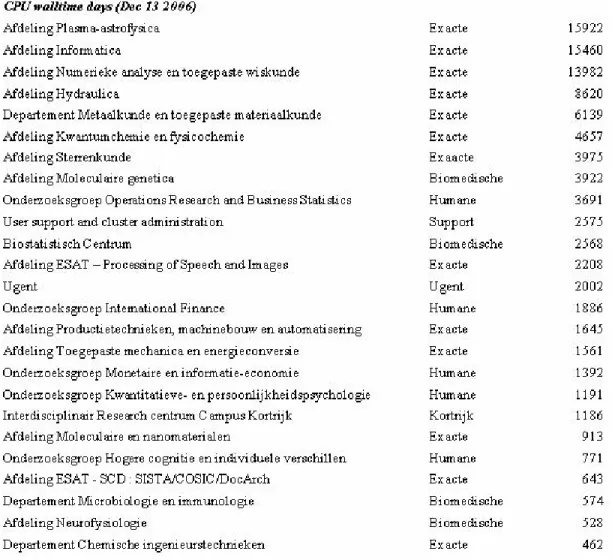

In totaal werden al 561075 rekenjobs aangeboden en met succes uitgerekend op de cluster. De cluster heeft in totaal (op 13 december 2006) al 102103 cpu-dagen (280 cpu-jaren) ge-rekend. In Fig. 3 wordt een overzicht gegeven van het gebruik van de HPC-infrastructuur en de verdeling van het verbruik over de verschillende klassen van gebruikersgroepen.

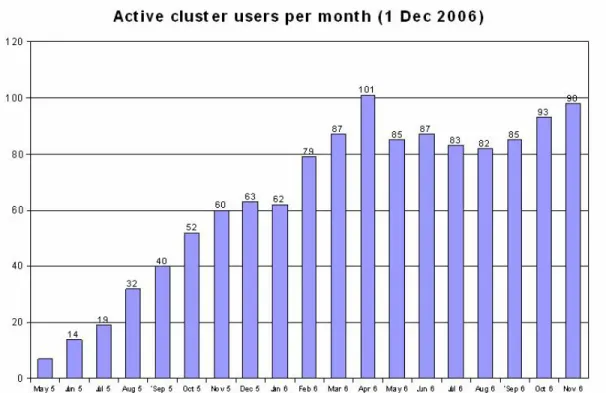

Het aantal effectieve gebruikers is natuurlijk niet op elk moment gelijk aan het totaal aantal onderzoekers die toegang hebben tot het systeem. In Fig. 4 wordt een overzicht gegeven van het aantal actieve gebruikers van de HPC-infrastructuur per maand. Dit

Figuur 3: Overzicht van het gebruik van de HPC-infrastructuur.

Figuur 4: Overzicht van het het aantal actieve gebruikers van de HPC-infrastructuur per maand.

aantal schommelt momenteel rond de 100.

In Fig. 5 en Fig. 6 wordt de globale hoeveelheid rekentijd die per maand werd aan-gevraagd weergegeven, zowel in termen van het aantal aan-gevraagde CPU-jaren (per maand en cumulatief) als in termen van het aantal jobs (eveneens per maand en cumulatief) die werden uitgevoerd.

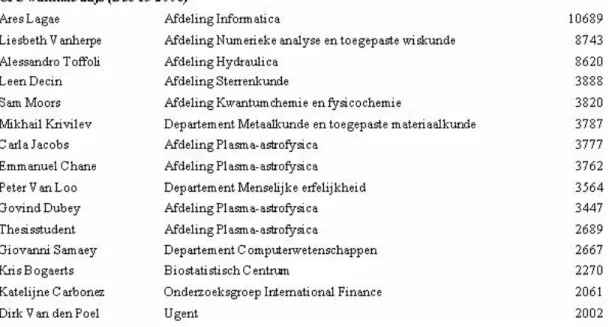

In Fig. 7 wordt een lijst weergegeven van de grootste gebruikersgroepen in termen van het aantal verbruikte cpu-dagen. Opmerkelijk is dat de top van deze lijst niet overeen-stemt met de 18 onderzoeksgroepen in de oorspronkelijke aanvraag. De afdeling Infor-matica is bijvoorbeeld de tweede grootste gebruiker van de infrastructuur, maar behoort niet tot de initiatiefnemers van het impulsproject. Bovendien horen de grootste en de vierde-grootste individuele gebruikers van de HPC-infrastructuur zelfs niet tot ´e´en van deze 18 groepen! Dit blijkt uit Fig. 8 waarin de 15 grootste individuele gebruikers (´en hun verbruik) worden opgesomd. het feit dat er al 380 gebruikers zin uit 98 ver-schillende ondersoeksgroepen betekent dat de nood aan rekenkracht nog heel

Figuur 5: Overzicht van de aangevraagde rekentijd in termen van het het aantal aange-boden jobs per maand en cumulatief.

Figuur 6: Overzicht van de aangevraagde rekentijd in termen van het aantal gevraagde CPU-jaren (!) per maand en cumulatief.

Figuur 7: Lijst van de 25 grootste onderzoeksgroepen in termen van het aantal verbruikte cpu-dagen.

veel groter en nog veel meer verspreid was (en is) dan oorsponkelijk werd voorzien door de initiatiefnemers van dit project.

4.3

Externe gebruikers

In de oorspronkelijke aanvraag werd voorzien dat de HPC-infrastructuur pas in het derde jaar opengesteld zou worden voor externe gebruikers en dan nog alleen in het geval van eventuele restcapaciteit. Er werden dus nog geen acties ondernomen om externe gebruikers aan te trekken. Er bleek evenwel enige interesse van externe gebruikers.

Van de firma Bosch Belgi¨e hebben we de vraag ontvangen onder welke voorwaarden ze de cluster kunnen gebruiken voor eindige-elementen-simulaties (Abaqus) toepassingen. Dit werd door de Stuurgroep HPC gezien als een goed testgeval om eventuele restcapaciteit tegen betaling te laten benutten door externe gebruikers. De opbrengst hiervan kan dan weer in HPC ge¨ınvesteerd worden. LUDIT zal nagaan wat Bosch precies verlangt en een voorstel uitwerken voor verrekening van het cpu-gebruik, liefst op basis van vergelijking met andere academische clusters.

Figuur 8: Lijst van de 15 grootste gebruikers in termen van het aantal verbruikte cpu-dagen.

Er kwam ook een vraag via Stefaan Cottenier (fac. Wetenschappen, dept. Fysica) om tijdelijk toegang te verlenen aan een externe firma om deze firma toe te laten ‘libraries’ te optimaliseren. Het account dat hiervoor werd aangemaakt, werd tot nu toe echter slechts minimaal gebruikt.

4.4

Gebruiksplanning voor eerstvolgende jaar (2007)

Begin 2007 zal het extra gedeelte van 120 rekennodes (480 CPUs), dat nu gebruikt wordt door de winnaars van de ‘Great Challenge’-wedstrijd (zie hieronder), ter beschikking ko-men van de andere gebruikers. De scheduling van de jobs die door de gebruikers worden aangeboden, zal verder gebeuren volgens het ‘fair share’ principe dat hierboven beschre-ven werd. De Stuurgroep HPC zal er verder over waken dat het verwerken van de jobs vlot verloopt en eventueel de ‘fair share’-formule aanpassen indien dit nodig mocht blijken.

5

Gebruikersondersteuning, stimulansen

en PR

Voor de ondersteuning van het HPC-gebruik werd Dr. Jan De Laet aangeworven op het HPC-budget (niet van het deel van de impulsfinanciering maar van het deel dat door de gebruikers zelf werd bijgedragen). Jan De Laet geeft individuele ondersteuning op aan-vraag en verzorgt ook infosessies en cursussen over de verschillende aspecten van parallel rekenen op een computercluster. Jan De laet ´en de gebruikers zelf zorgen bovendien voor documentatie via de wiki site van dit project.

5.1

Cursussen

Tot nu toe werden er in totaal 7 infosessies/cursussen ingericht over rekenen op de cluster, met in totaal 142 deelnemers.

De meest recente cluster infosessie, “Introduction HPC cluster”, vond plaats op 30 oktober 2006 en was volzet (25 inschrijvingen).

De cursus ‘Introduction SAS on HPC cluster’ die begin november 2006 een eerste keer werd ingericht, was met 20 deelnemers eveneens volzet.

De recentste cursus handelde over MPI, ‘Introduction to parallel programming using MPI’ (twee maal drie uur), en ging door op 5 en 6 december 2006.

Verder plannen we voor de toekomst ook nog andere infosessies, zoals bijvoorbeeld over openDX op de cluster (visualisatie).

5.2

HPC studiedag

De eerste HPC studiedag vond plaats op vrijdag 24 maart 2006. Zowel wat betreft aantal deelnemers als wat betreft inhoud was de studiedag een succes. Vooraf waren er 86 in-schrijvingen en op de dag zelf zat het auditorium (ongeveer 100 plaatsen) zo goed als vol. Inhoudelijk kregen we een mooie impressie van hoe de cluster voor toepassingen uit uit-eenlopende domeinen gebruikt wordt met bijdragen als “Large scale quantum scattering calculations on VIC” van Wim Vanroose (Department of Computer Science, Scientific Computing Research Group), “The ’shocking’ truth about Space Weather!” van Carla Jacobs (Department of Mathematics, Centre for Plasma Astrophysics)”, “Walking on a ragged energy surface. Methodology and application in Molecular simulation” van Ting Li (Department of Chemistry, Molecular and nano-materials), “High Performance Com-puting Applications in Computer Graphics” van Ares Lagae (Department of computer science, Computer graphics) en “High Performance Computing for Computational Sta-tistics and Data Mining: Applications in Marketing” van Dirk Van den Poel (Associate Professor of Marketing, UGent).

Het werk dat Wim Vanroose voorstelde werd deels uitgevoerd op de nieuwe HPC-infrastructuur en heeft tot een publicatie in Science geleid.

Tijdens de studiedag vroegen Patrick De Causmaecker en Koen Van Den Abeele (KU-LAK) of het mogelijk was om ook aan de KULAK eens een inleiding tot parallel program-meren met behulp van MPI te geven. Jan De Laet zorgde hiervoor op 19 april, voor een twaalftal deelnemers.

5.3

‘Great challenge’-wedstrijd

Naar aanleiding van de recente aanzienlijke uitbreiding van de cluster, lanceerde de HPC stuurgroep een “GREAT CHALLENGE” wedstrijd. In deze wedstrijd konden onderzoe-kers een beknopte aanvraag indienen over een moeilijk probleem dat ze kunnen oplossen mits ze over voldoende rekenkracht beschikken. De winnaar(s) van de wedstrijd kunnen momenteel voor een beperkte periode volledig beschikken over het nieuwe gedeelte van de cluster (de 120 extra rekennodes (480 processoren)) om het probleem dat ze voorstelden effectief op te lossen.

Er kwamen 9 aanvragen binnen en de Stuurgroep HPC heeft deze aanvragen ge¨evalueerd. Twee aanvragen werden niet als ‘challenge’ erkend in de zin dat ze ook met de beschikbare

HPC-infrastructuur (v´o´or de uitbreiding dus) konden worden uitgevoerd en de aanvra-gers werden aangemoedigd hun project meteen uit te voeren. Hiervoor werd bovendien ondersteuning aangeboden. Twee andere aanvragen bleken typische GRID-toepassingen (weinig of geen communicatie vereist tussen de nodes) en de aanvragers werden erop at-tent gemaakt dat er naast de HPC ook GRID-capaciteit is en werden aangemoedigd hun project in dit kader te implementeren. ook hiervoor werd ondersteuning aangeboden. De overige voorstellen werden als volgt gehonoreerd:

1. het project ‘3D CME simulaties van Zon tot Aarde’ van Carla Jacobs, Bart van der Holst (CPA, Dept. Wiskunde) kreeg 120 nodes ter beschikking gedurende 10 dagen (de helft van wat gevraagd werd);

2. het project ‘Relativistic magnetized jet simulations: Astrophysics with B to c’ van Rony Keppens (Centre for Plasma Astrophysics) kreeg 30 nodes ter beschikking gedurende 30 dagen;

3. het project ‘Numerical Simulation of Chemically Reactive Air Flow around the EXPERT Space Vehicle’ van Dries Kimpe (TWR), J. Molnar (VKI), A. Lani (VKI), T. Quintino (VKI), D. Vanden Abeele (VKI), en T. Wuilbaut (VKI) kreeg 120 nodes ter beschikking gedurende 10 dagen;

4. het project ‘Driedimensionale simulaties voor korrelgroei in kristallijnen materialen met fijnverdeelde tweedefase deeltjes’ van Nele Moelans en Liesbeth Vanherpe (De-partement MTM en De(De-partement CW) kreeg 120 nodes ter beschikking gedurende 5 dagen;

5. het project ‘Assessment of total body dose due to scattered radiation in clinical proton therapy’ van Frank Van den Heuvel (Department of Experimental Radiothe-rapy) kreeg 120 nodes ter beschikking gedurende 10 dagen.

Alle voorstellen kregen dus een kans en zullen (eventueel gedeeltelijk) worden uitgevoerd!

5.4

PR

Bij de opstart van de cluster, in mei 2005, werd een tekst ingezonden naar de Campus-krant. Ook in de e-Nieuwsbrief verscheen een bericht over de HPC cluster en de moge-lijkheid voor K.U.Leuven onderzoekers om daarop te rekenen. De ‘call’ voor de ‘Great Challenge’-wedstrijd werd verspreid via de e-Nieuwsbrief en via Email. In de e-nieuwsbrief van eind oktober 2006 verscheen eveneens een artikel over de uitbreiding.